Chat GPT 5.1 업데이트 정리

- -

안녕하세요! 갓대희입니다.

오늘은 2025년 11월 12일 새로 업데이트된 GPT-5.1 내용에 대해 아주 상세히 정리해 보려고 한다.

OpenAI가 2025년 8월 GPT-5를 공개한 지 약 3개월 만에 첫 번째 메이저 업데이트인 GPT-5.1을 발표했다.

이번 업데이트는 "Smarter, More Conversational(더 똑똑하고, 더 대화하는)"이라는 슬로건 아래 사용자 피드백을 적극 반영하여 대화의 자연스러움과 지시 준수 능력을 대폭 강화했으며, 개발자를 위한 기술적 개선사항도 다수 포함되었다.

기존 GPT-5 대비 향상된 대화 능력, 적응형 추론, 그리고 개발자 친화적인 성능 개선을 제공한다고 하니 한번 알아보자.

GPT-5.1 출시 개요

OpenAI는 2025년 11월 12일 공식 블로그를 통해 GPT-5.1 출시를 발표했다. 이번 업데이트는 GPT-5 출시 이후 수집된 사용자 피드백, 특히 "GPT-4.0의 톤과 대화 방식이 더 좋았다"는 의견을 적극 반영했다고 한다.

GPT-5.1: A smarter, more conversational ChatGPT | OpenAI

GPT-5.1은 크게 두 가지 모델로 출시되었으며, 각각 다른 사용 사례에 최적화되어 있다. 본격적인 GPT-5.1 설명에 앞서, 먼저 GPT-5의 강력한 성능부터 살펴보자.

GPT-5: 압도적 성능의 통합 시스템

2025년 8월 공개된 GPT-5는 단순히 GPT-4o를 개선한 모델이 아니었다. GPT-5의 가장 큰 특징은 기존의 빠른 응답 모델(GPT-4o)과 깊이 있는 추론 모델(o3)을 하나의 통합 시스템으로 구축했다는 점이다.

GPT-5 통합 시스템 작동 원리

- 라우터가 사용자의 질문 의도를 분석

- 간단한 작업은 기본 모델에 배정

- 복잡한 문제는 'Thinking' 모델에 배정

GPT-5 핵심 성능 지표

GPT-5는 여러 전문 분야에서 압도적인 성능을 입증했다.

• 코딩: SWE-bench Verified에서 74.9% 기록 (업계 최고 수준)

• 수학: AIME 2025(수학 올림피아드 수준)에서 94.6%라는 경이로운 점수 달성

• 환각 감소: 생성형 AI의 고질적 문제였던 환각(Hallucination) 현상 대폭 감소

• 오류율: GPT-4o 대비 최대 20% 감소, 추론 모드에서는 최대 70%까지 오류 감소

GPT-5.1 특징

GPT-5.1의 혁신 포인트중 하나는 '적응형 추론 시간(Adaptive Reasoning Time)' 도입이다.

GPT-5.1은 작업의 복잡도에 따라 두 가지 모드를 스스로 선택한다. 간단한 대화는 빠른 'Instant 모드'로 대응하고, 깊은 사고가 필요한 문제는 잠시 멈춰 생각하는 'Thinking 모드'로 처리한다. 이를 통해 AI가 효율과 성능의 완벽한 균형을 스스로 조절하며 추론 효율성을 극대화를 이끌어 낼 수 있게 한다.

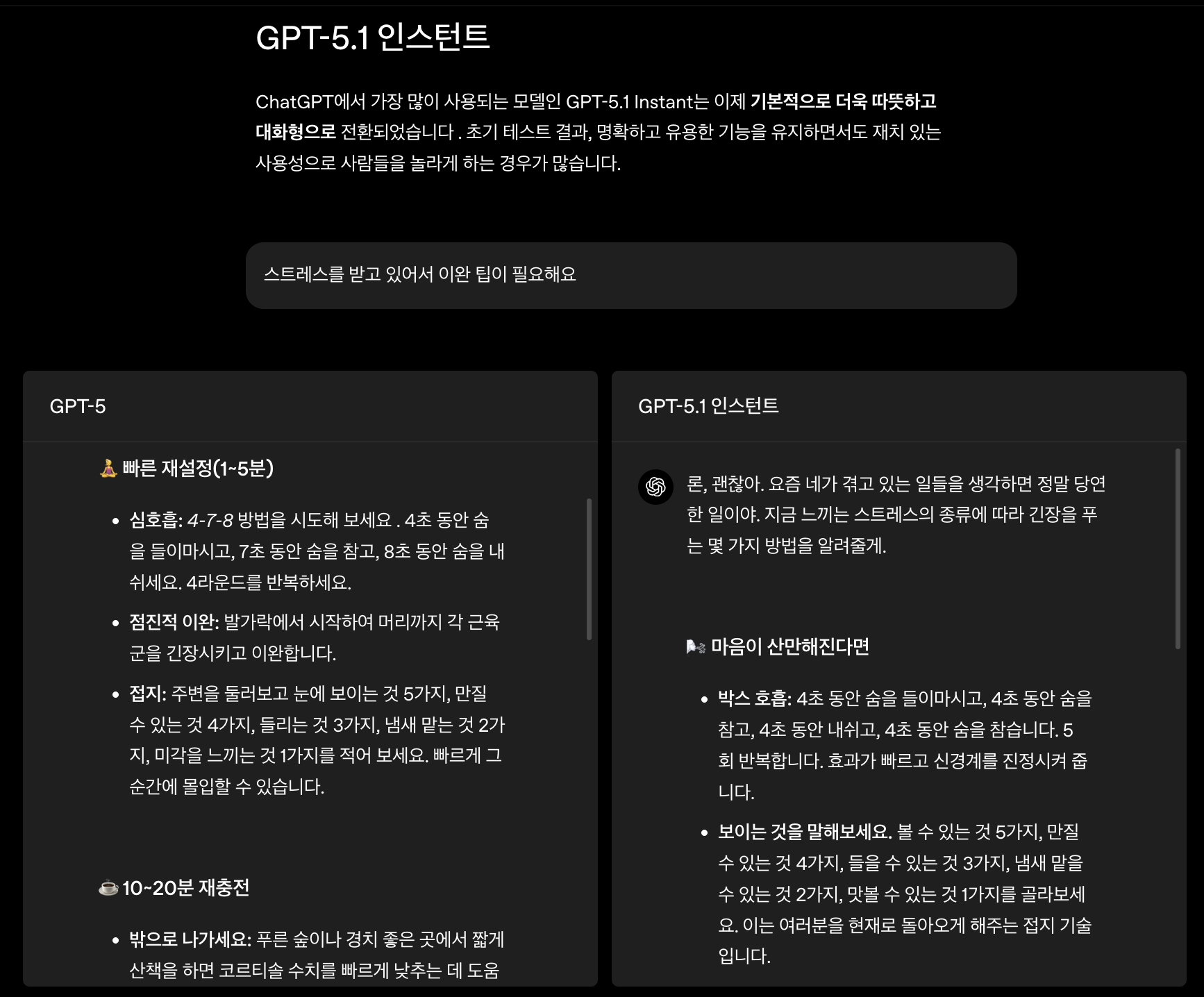

GPT-5.1 Instant

공식 문서에 따르면, GPT-5.1 Instant는 "더 따뜻하고(warmer), 더 지능적이며(more intelligent), 사용자의 지시를 더 잘 따르는(better at following your instructions)" 모델로 설계되었다고 한다.

• 적응형 추론(Adaptive Reasoning): 질문의 복잡도를 판단하여 필요할 때만 추론 과정을 거친다.

• 향상된 지시 준수: 사용자가 제공한 제약 조건이나 형식 요구사항을 더욱 정확하게 따른다

• 대화형 응답: 기계적인 답변 대신 자연스러운 대화 방식으로 소통한다

• 컨텍스트 창: 플랜에 따라 16K~128K 토큰 지원 (무료 16K, Plus/Business 32K, Pro/Enterprise 최대 128K)

GPT-5.1 Thinking

GPT-5.1 Thinking 모델은 "이해하기 쉬워졌으며, 간단한 작업에서는 더 빠르고, 복잡한 작업에서는 더 지속적으로(persistent) 사고한다"는 특징을 가지고 있다.

적응형 사고 시간

- 쉬운 질문: GPT-5 대비 약 2배 빠른 응답 속도

- 평균 난이도 질문: 기존과 비슷한 사고 시간

- 복잡한 질문: 필요에 따라 더 오래 사고하여 정확도 향상

컨텍스트 창: 최대 196K 토큰 지원으로 더 긴 문서와 복잡한 분석 가능

※ 공식 문서에 따르면, 일반적인 ChatGPT 작업 분포에서 GPT-5.1 Thinking은 가장 빠른 작업에서는 GPT-5 Thinking 대비 약 2배 빠르게, 가장 느린 작업에서는 약 절반 속도로 실행되어 필요에 따라 사고 시간을 최적화한다고 한다.

GPT-5.1 Instant vs Thinking 상세 비교

| 비교 항목 | GPT-5.1 Instant | GPT-5.1 Thinking |

|---|---|---|

| 주요 목적 | 빠르고 대화형, 일상 업무 처리 | 복잡한 다단계 문제 심층 추론 |

| 추론 방식 | 경량 적응형 추론 | 정밀한 사고 시간 조절 |

| 응답 속도 | 매우 빠름 (저지연 최적화) | 복잡한 작업에서는 느림 |

| 응답 스타일 | 간결하고 대화형 | 철저하고 체계적인 설명 |

| 컨텍스트 창 | 16K~128K 토큰 (플랜별) | 최대 196K 토큰 |

| 최적 활용 사례 | 일상 채팅, 브레인스토밍, 짧은 코드, 초안 작성 | 연구, 디버깅, 장문서 분석, 다단계 계획 |

| 트레이드오프 | 속도 > 깊이 | 깊이 > 속도 |

GPT-5.1 Auto

GPT-5.1 Auto는 사용자의 요청을 자동으로 분석하여 Instant와 Thinking 중 최적의 모델을 선택하는 지능형 라우팅 시스템이다.

• 프롬프트와 대화 기록의 신호를 분석

• 유사한 프롬프트에서의 모델 성공 패턴 학습

• "더 생각할지" 또는 "즉시 응답할지" 자동 결정

• 사용자는 모델을 직접 선택할 필요 없이 최적화된 응답 수신

주요 개선사항

1. 향상된 대화 능력과 성격

GPT-5 출시 당시 많은 사용자들이 "대화하기 지루하다(boring to talk to)"는 피드백을 제공했고, OpenAI는 이를 적극 반영하여 GPT-5.1에 더 풍부한 성격(personality)을 구축했다.

공식 테스트에 따르면, 동일한 질문("I'm feeling stressed and could use some relaxation")에 대해 GPT-5는 형식적인 리스트 형태로 답변한 반면, GPT-5.1은 사용자의 메모리를 참조하며 친구가 문자를 보내는 것처럼 자연스럽고 공감적인 답변을 제공했다.

확장된 톤 개인화 옵션

GPT-5.1은 다양한 대화 스타일을 제공하여 사용자가 원하는 톤을 쉽게 설정할 수 있다.

7가지 대화 스타일

- 기본: 균형 잡히고 자연스러운 톤

- 친근: 따뜻하고 수다스러운 스타일

- 효율: 간결하고 직접적인 답변

- 전문적: 공식적이고 정확한 표현

- 솔직(Candid): 개방적이고 격려적인 톤

- 엉뚱한(Quirky): 창의적이고 재미있는 스타일

- 괴짜/냉소적: 이전 버전에서 유지된 옵션

2. 지시 준수 능력 강화

OpenAI 공식 블로그에서 제시한 예시에서, "항상 6단어로 응답하라"는 지시를 GPT-5는 따르지 못했으나, GPT-5.1 Instant는 정확히 6단어로만 응답하여 지시 준수 능력이 크게 향상되었음을 확인할 수 있다.

3. 전문 용어 감소 및 명확성 향상

GPT-5.1 Thinking 모델은 전문 용어(jargon)를 덜 사용하도록 설계되어, 복잡한 기술적 내용도 더 쉽게 이해할 수 있도록 설명한다. 필요시 더 상세한 설명을 요청할 수 있는 옵션도 제공된다.

GPT-5 vs GPT-5.1 핵심 비교

GPT-5와 GPT-5.1의 주요 차이점을 한눈에 비교해보자.

| 비교 기준 | GPT-5 | GPT-5.1 |

|---|---|---|

| 모드 메커니즘 | 단일 통합 시스템 | 듀얼 모드 (Instant + Thinking) |

| 추론 능력 | 강력한 추론 | 적응형 추론 시간 포함 |

| 자연어 처리 | 표준 수준 | 감정적 온기, 높은 논리적 연결 |

| 페르소나/톤 | 기본 옵션 | 7가지 페르소나 어조 |

| 사용자 경험 | 기술 중심 | 인간 중심의 이해와 반응 |

| 자동 라우팅 | 내부 라우팅 | GPT-5.1 Auto 선택 가능 |

| 지시 준수 | 기본 | 대폭 향상 |

※ GPT-5가 '압도적인 두뇌'라면, GPT-5.1은 그 두뇌를 가장 효율적으로 사용하는 '현명한 파트너'라고 할 수 있다.

개발자를 위한 기술적 향상

OpenAI는 개발자를 위한 별도의 공식 문서를 통해 API 및 기술적 개선사항을 상세히 공개했다.

Introducing GPT-5.1 for developers | OpenAI

추론 모드 제어 : 'none' 옵션 추가

GPT-5.1은 새로운 추론 모드인 'none'을 도입했다. 이는 지연 시간에 민감한 워크로드에 이상적이며, GPT-4.1 및 이전 비추론 모델과 유사한 방식으로 작동한다.

추론 모드 선택 가이드

• none: 지연 시간 최소화 (최고 속도, 단순 작업)

• low: 빠른 응답 필요 작업 (코딩, 지시 따르기)

• medium: 균형잡힌 작업 (기본값)

• high: 복잡한 추론 필요 (수학, 복잡한 문제 해결)

확장된 캐싱 : 최대 24시간

공식 문서에 따르면, 프롬프트 캐싱 기간이 최대 24시간으로 연장되어 다음과 같은 이점을 제공한다.

- 낮은 지연 시간: 반복 요청에 대한 응답 속도 향상

- 비용 절감: 캐시된 프롬프트 재사용으로 최대 90% 비용 감소

- 원활한 성능: 멀티턴 채팅, 코딩 세션, 지식 검색 워크플로우에서 향상된 경험

툴 콜링 성능 개선

Sierra의 실제 평가에 따르면, GPT-5.1은 "no reasoning" 모드에서 GPT-5의 최소 추론 모드 대비 저지연 툴 콜링 성능이 20% 향상되었다.

전체 응답 속도 향상

대화형 텍스트 생성에서 GPT-5.1은 GPT-4o 대비 30% 더 빠른 속도를 보여주며, Priority Processing 고객은 GPT-5 대비 GPT-5.1에서 현저히 빠른 성능을 경험할 수 있다.

비용 효율성 및 활용 전략

GPT-5의 컴퓨팅 효율성

GPT-5는 이전 세대의 심층 추론 모델(o3)보다 50~80% 적은 컴퓨팅 자원으로 동일하거나 더 나은 결과를 낸다고 한다. 이는 대규모 데이터 분석이나 복잡한 연산을 수행할 때 상당한 비용 절감으로 이어질 수 있다.

GPT-5.1의 적응형 효율성

GPT-5.1은 여기서 한 단계 더 나아간다. '적응형 듀얼 모드'는 모든 작업에 최대 성능을 사용하지 않고, 필요한 만큼만 자원을 할당해서 효율을 극대화한다.

• 간단한 이메일 초안: Instant 모드로 비용 최소화

• 복잡한 비즈니스 전략 보고서: Thinking 모드로 정확도 극대화

• 혼합 업무: Auto 모드로 자동 최적화

성능 벤치마크 비교

| 벤치마크 | GPT-4o | GPT-5 | GPT-5.1 | 개선율 |

|---|---|---|---|---|

| SWE-bench Verified | - | 72.8% | 76.3% | +3.5%p |

| AIME 2025 (수학) | - | 94.6% | 향상 | - |

| 오류율 감소 | 기준 | -20% | 향상 지속 | 추론 시 -70% |

| 툴 콜링 성능 | - | 기준 | 향상 | +20% |

| 응답 속도 | 기준 | - | 향상 | +30% |

| 컴퓨팅 자원 | - | 효율적 | 더 효율적 | o3 대비 -50~80% |

※ 모든 수치는 OpenAI 공식 문서 및 파트너사(Sierra) 벤치마크를 기반으로 표현하였다.

코딩 능력 향상

공식 블로그에 따르면, GPT-5.1은 특히 코딩 분야에서 개선을 보였다. SWE-bench Verified에서 GPT-5의 72.8%에서 76.3%로 향상되었으며, 추론 토큰을 18,000개까지 확장할 수 있어 더 복잡한 코딩 문제를 해결할 수 있다.

공식 문서에서는 "더 많은 사고(thinking)가 더 높은 결과로 이어진다"고 강조하며, 복잡한 코딩 작업에는 추론 모드를 'high'로 설정할 것을 권장하고 있다.

API 접근

개발자는 OpenAI 플랫폼 API를 통해 GPT-5.1 모델에 접근할 수 있다.

•

gpt-5.1-chat-latest → GPT-5.1 Instant•

gpt-5.1 → GPT-5.1 Thinking (적응형 추론 포함)• 두 모델 모두 채팅 엔드포인트에서 적응형 추론 기능 제공

이로써 간단하게 GPT-5.1의 변경된 부분, 특징들에 대해 알아보았다. 이제 실무에 바로 적용할 수 있는 개발 예제를 통해 GPT-5.1을 효과적으로 활용하는 방법을 알아보자.

개발 환경 설정

1단계: 필수 패키지 설치

pip install openai python-dotenv tiktoken패키지 설명

- openai: OpenAI 공식 Python SDK

- python-dotenv: 환경 변수 관리 (.env 파일)

- tiktoken: 토큰 카운팅 및 비용 계산

2단계: 환경 변수 설정

프로젝트 루트에 .env 파일을 생성하여 API 키를 안전하게 관리하자.

OPENAI_API_KEY=sk-your-api-key-here

OPENAI_ORG_ID=org-your-org-id # 선택사항import os

from dotenv import load_dotenv

from openai import OpenAI

# .env 파일 로드

load_dotenv()

# 클라이언트 초기화

client = OpenAI(

api_key=os.getenv("OPENAI_API_KEY"),

organization=os.getenv("OPENAI_ORG_ID") # 선택사항

)✅ .env 파일을 .gitignore에 추가

✅ API 키를 코드에 하드코딩하지 말 것

✅ 프로덕션 환경에서는 환경 변수나 AWS Secrets Manager 사용

✅ 정기적으로 API 키 로테이션

실전 API 활용

기본 채팅 완성

from openai import OpenAI

client = OpenAI()

response = client.chat.completions.create(

model="gpt-5.1-chat-latest", # GPT-5.1 Instant

messages=[

{"role": "system", "content": "당신은 친절한 Python 튜터입니다."},

{"role": "user", "content": "리스트 컴프리헨션을 설명해주세요."}

],

temperature=0.7,

max_tokens=500

)

print(response.choices[0].message.content)

print(f"\n사용 토큰: {response.usage.total_tokens}")

스트리밍 응답 (실시간 UI 업데이트)

실시간으로 응답을 받아 사용자에게 점진적으로 표시하는 방법이다. ChatGPT처럼 타이핑 효과를 구현할 수 있다.

def stream_chat(messages):

"""스트리밍 방식으로 GPT-5.1 응답 받기"""

stream = client.chat.completions.create(

model="gpt-5.1-chat-latest",

messages=messages,

stream=True, # 스트리밍 활성화

temperature=0.7

)

full_response = ""

for chunk in stream:

if chunk.choices[0].delta.content:

content = chunk.choices[0].delta.content

full_response += content

print(content, end="", flush=True) # 실시간 출력

print() # 줄바꿈

return full_response

# 사용 예제

messages = [

{"role": "user", "content": "FastAPI로 간단한 REST API 만드는 법을 설명해주세요."}

]

response = stream_chat(messages)• 웹 채팅 인터페이스에서 실시간 응답 표시

• 긴 답변에서 사용자 대기 시간 개선

• SSE(Server-Sent Events)와 함께 사용하여 웹소켓 대체

• CLI 도구에서 타이핑 효과 구현

함수 콜링 (Tool Calling)

툴 콜링 성능을 활용하여 외부 API나 데이터베이스와 연동하는 방법이다.

import json

# 1. 사용 가능한 함수 정의

tools = [

{

"type": "function",

"function": {

"name": "get_weather",

"description": "특정 도시의 현재 날씨 정보를 가져옵니다",

"parameters": {

"type": "object",

"properties": {

"location": {

"type": "string",

"description": "도시 이름 (예: Seoul, Busan)"

},

"unit": {

"type": "string",

"enum": ["celsius", "fahrenheit"],

"description": "온도 단위"

}

},

"required": ["location"]

}

}

}

]

# 2. 실제 날씨 API 호출 함수 (예시)

def get_weather(location, unit="celsius"):

"""실제 날씨 API 호출 (여기서는 더미 데이터 반환)"""

# 실제로는 OpenWeatherMap 등의 API 호출

weather_data = {

"Seoul": {"temp": 15, "condition": "맑음"},

"Busan": {"temp": 18, "condition": "흐림"}

}

return json.dumps(weather_data.get(location, {"error": "도시를 찾을 수 없습니다"}))

# 3. GPT-5.1에 함수 콜링 요청

messages = [{"role": "user", "content": "서울 날씨 어때?"}]

response = client.chat.completions.create(

model="gpt-5.1-chat-latest",

messages=messages,

tools=tools,

tool_choice="auto"

)

# 4. 함수 호출이 필요한지 확인

response_message = response.choices[0].message

tool_calls = response_message.tool_calls

if tool_calls:

# 5. 함수 실행

messages.append(response_message)

for tool_call in tool_calls:

function_name = tool_call.function.name

function_args = json.loads(tool_call.function.arguments)

# 함수 실행

function_response = get_weather(**function_args)

# 6. 함수 결과를 메시지에 추가

messages.append({

"tool_call_id": tool_call.id,

"role": "tool",

"name": function_name,

"content": function_response

})

# 7. 최종 응답 생성

final_response = client.chat.completions.create(

model="gpt-5.1-chat-latest",

messages=messages

)

print(final_response.choices[0].message.content)• 데이터베이스 조회: 사용자 질문에 맞춰 SQL 쿼리 자동 생성 및 실행

• 외부 API 통합: 날씨, 주식, 뉴스 등 실시간 데이터 조회

• 계산 작업: 복잡한 수학 계산을 Python 함수로 정확하게 처리

• 시스템 제어: 이메일 발송, 파일 생성 등 작업 자동화

비동기 처리 (성능 최적화)

여러 요청을 동시에 처리하여 전체 처리 시간을 단축하는 방법이다.

import asyncio

from openai import AsyncOpenAI

# 비동기 클라이언트 초기화

async_client = AsyncOpenAI()

async def translate_text(text, target_lang):

"""텍스트를 비동기로 번역"""

response = await async_client.chat.completions.create(

model="gpt-5.1-chat-latest",

messages=[

{"role": "system", "content": f"다음 텍스트를 {target_lang}로 번역하세요."},

{"role": "user", "content": text}

]

)

return response.choices[0].message.content

async def batch_translate():

"""여러 텍스트를 동시에 번역 (병렬 처리)"""

texts = [

("Hello, how are you?", "한국어"),

("Good morning", "일본어"),

("Thank you very much", "중국어")

]

# 모든 번역 작업을 동시에 실행

tasks = [translate_text(text, lang) for text, lang in texts]

results = await asyncio.gather(*tasks)

# 결과 출력

for (original, lang), translated in zip(texts, results):

print(f"{original} → ({lang}) {translated}")

# 실행

asyncio.run(batch_translate())• 3개 요청 순차 처리: 약 9초 소요

• 3개 요청 병렬 처리: 약 3초 소요 (3배 빠름)

• Rate Limit 내에서 최대한 많은 요청을 효율적으로 처리 가능

토큰 카운팅 및 비용 계산

프로덕션 환경에서 비용을 모니터링하고 최적화하기 위한 코드

import tiktoken

# GPT-5.1용 인코더 로드

encoding = tiktoken.encoding_for_model("gpt-4") # GPT-5.1은 GPT-4 인코딩 사용

def count_tokens(text, model="gpt-5.1"):

"""텍스트의 토큰 수 계산"""

return len(encoding.encode(text))

def estimate_cost(input_tokens, output_tokens, model="gpt-5.1-instant"):

"""API 호출 비용 예측 (2025년 가격 기준 예시)"""

# 가격표 (실제 가격은 OpenAI 공식 페이지 확인 필요)

pricing = {

"gpt-5.1-instant": {

"input": 0.003, # $0.003 per 1K tokens

"output": 0.015 # $0.015 per 1K tokens

},

"gpt-5.1-thinking": {

"input": 0.005,

"output": 0.025

}

}

if model not in pricing:

model = "gpt-5.1-instant"

input_cost = (input_tokens / 1000) * pricing[model]["input"]

output_cost = (output_tokens / 1000) * pricing[model]["output"]

return {

"input_cost": input_cost,

"output_cost": output_cost,

"total_cost": input_cost + output_cost,

"input_tokens": input_tokens,

"output_tokens": output_tokens

}

# 사용 예제

prompt = "Python으로 웹 스크래핑하는 방법을 자세히 설명해주세요."

input_tokens = count_tokens(prompt)

print(f"입력 토큰 수: {input_tokens}")

print(f"예상 출력 토큰 (500개 가정):")

cost = estimate_cost(input_tokens, 500)

print(f" - 입력 비용: ${cost['input_cost']:.6f}")

print(f" - 출력 비용: ${cost['output_cost']:.6f}")

print(f" - 총 비용: ${cost['total_cost']:.6f}")

# 실제 API 호출 후 정확한 비용 계산

response = client.chat.completions.create(

model="gpt-5.1-chat-latest",

messages=[{"role": "user", "content": prompt}]

)

actual_cost = estimate_cost(

response.usage.prompt_tokens,

response.usage.completion_tokens

)

print(f"\n실제 사용:")

print(f" - 총 비용: ${actual_cost['total_cost']:.6f}")

print(f" - 입력: {actual_cost['input_tokens']} 토큰")

print(f" - 출력: {actual_cost['output_tokens']} 토큰")

멀티턴 대화 관리

컨텍스트를 유지하면서 여러 턴의 대화를 관리하는 패턴

class ConversationManager:

"""GPT-5.1 대화 세션 관리"""

def __init__(self, system_message=None, max_history=10):

self.messages = []

self.max_history = max_history

if system_message:

self.messages.append({

"role": "system",

"content": system_message

})

def add_user_message(self, content):

"""사용자 메시지 추가"""

self.messages.append({

"role": "user",

"content": content

})

def add_assistant_message(self, content):

"""AI 응답 추가"""

self.messages.append({

"role": "assistant",

"content": content

})

def trim_history(self):

"""오래된 대화 제거 (시스템 메시지는 유지)"""

if len(self.messages) > self.max_history + 1:

# 시스템 메시지(첫 번째)는 유지하고 나머지만 제한

system_msg = self.messages[0] if self.messages[0]["role"] == "system" else None

conversation = self.messages[1:] if system_msg else self.messages

# 최근 N개만 유지

trimmed = conversation[-(self.max_history):]

self.messages = [system_msg] + trimmed if system_msg else trimmed

def chat(self, user_input, model="gpt-5.1-chat-latest"):

"""대화 진행"""

self.add_user_message(user_input)

response = client.chat.completions.create(

model=model,

messages=self.messages,

temperature=0.7

)

assistant_reply = response.choices[0].message.content

self.add_assistant_message(assistant_reply)

# 히스토리 관리

self.trim_history()

return assistant_reply

def get_token_count(self):

"""현재 대화의 총 토큰 수 계산"""

total = 0

for msg in self.messages:

total += count_tokens(msg["content"])

return total

# 사용 예제

conversation = ConversationManager(

system_message="당신은 Python 전문가입니다. 간결하고 실용적인 답변을 제공하세요."

)

# 대화 1

print("User: Python 리스트와 튜플의 차이는?")

reply1 = conversation.chat("Python 리스트와 튜플의 차이는?")

print(f"AI: {reply1}\n")

# 대화 2 (이전 컨텍스트 유지)

print("User: 그럼 언제 튜플을 사용하는게 좋아?")

reply2 = conversation.chat("그럼 언제 튜플을 사용하는게 좋아?")

print(f"AI: {reply2}\n")

# 토큰 사용량 확인

print(f"현재 대화 토큰 수: {conversation.get_token_count()}")

프로덕션 레벨 에러 처리

import time

import logging

from openai import OpenAI, APIError, RateLimitError, APIConnectionError

# 로깅 설정

logging.basicConfig(level=logging.INFO)

logger = logging.getLogger(__name__)

class GPT51Client:

"""프로덕션용 GPT-5.1 클라이언트"""

def __init__(self, api_key=None):

self.client = OpenAI(api_key=api_key)

self.request_count = 0

self.total_cost = 0.0

def chat_with_retry(

self,

messages,

model="gpt-5.1-chat-latest",

max_retries=3,

**kwargs

):

"""재시도 로직이 포함된 안전한 채팅 완성"""

for attempt in range(max_retries):

try:

response = self.client.chat.completions.create(

model=model,

messages=messages,

**kwargs

)

# 통계 업데이트

self.request_count += 1

cost = estimate_cost(

response.usage.prompt_tokens,

response.usage.completion_tokens

)

self.total_cost += cost['total_cost']

logger.info(f"요청 성공 | 비용: ${cost['total_cost']:.6f} | 누적: ${self.total_cost:.6f}")

return response

except RateLimitError as e:

wait_time = (2 ** attempt) + 1

logger.warning(f"Rate Limit 도달. {wait_time}초 후 재시도... ({attempt + 1}/{max_retries})")

if attempt < max_retries - 1:

time.sleep(wait_time)

else:

logger.error("최대 재시도 횟수 초과")

raise

except APIConnectionError as e:

logger.warning(f"연결 오류. 1초 후 재시도... ({attempt + 1}/{max_retries})")

if attempt < max_retries - 1:

time.sleep(1)

else:

logger.error("연결 실패: 네트워크를 확인하세요")

raise

except APIError as e:

logger.error(f"API 오류: {e.status_code} - {e.message}")

raise

except Exception as e:

logger.error(f"예상치 못한 오류: {str(e)}")

raise

raise Exception("최대 재시도 횟수 초과")

def get_stats(self):

"""사용 통계 반환"""

return {

"request_count": self.request_count,

"total_cost": self.total_cost

}

# 사용 예제

gpt_client = GPT51Client()

try:

response = gpt_client.chat_with_retry([

{"role": "user", "content": "안녕하세요!"}

])

print(response.choices[0].message.content)

# 통계 확인

stats = gpt_client.get_stats()

print(f"\n총 요청 수: {stats['request_count']}")

print(f"총 비용: ${stats['total_cost']:.6f}")

except Exception as e:

print(f"처리 실패: {e}")

FastAPI 통합 예제

실제 웹 서비스에서 GPT-5.1을 사용하는 코드 예시

from fastapi import FastAPI, HTTPException

from fastapi.responses import StreamingResponse

from pydantic import BaseModel

from openai import OpenAI

import json

app = FastAPI()

client = OpenAI()

class ChatRequest(BaseModel):

message: str

model: str = "gpt-5.1-chat-latest"

stream: bool = False

class ChatResponse(BaseModel):

reply: str

tokens_used: int

model: str

@app.post("/chat", response_model=ChatResponse)

async def chat_endpoint(request: ChatRequest):

"""일반 채팅 엔드포인트"""

try:

response = client.chat.completions.create(

model=request.model,

messages=[{"role": "user", "content": request.message}]

)

return ChatResponse(

reply=response.choices[0].message.content,

tokens_used=response.usage.total_tokens,

model=request.model

)

except Exception as e:

raise HTTPException(status_code=500, detail=str(e))

@app.post("/chat/stream")

async def stream_chat_endpoint(request: ChatRequest):

"""스트리밍 채팅 엔드포인트"""

async def event_generator():

try:

stream = client.chat.completions.create(

model=request.model,

messages=[{"role": "user", "content": request.message}],

stream=True

)

for chunk in stream:

if chunk.choices[0].delta.content:

content = chunk.choices[0].delta.content

# SSE 형식으로 전송

yield f"data: {json.dumps({'content': content})}\n\n"

yield "data: [DONE]\n\n"

except Exception as e:

yield f"data: {json.dumps({'error': str(e)})}\n\n"

return StreamingResponse(

event_generator(),

media_type="text/event-stream"

)

# 서버 실행: uvicorn main:app --reloadAPI 테스트 (cURL)

# 일반 요청

curl -X POST "http://localhost:8000/chat" \

-H "Content-Type: application/json" \

-d '{"message": "Python으로 REST API 만드는 법 알려줘"}'

# 스트리밍 요청

curl -X POST "http://localhost:8000/chat/stream" \

-H "Content-Type: application/json" \

-d '{"message": "FastAPI의 장점을 설명해줘", "stream": true}'

성능 벤치마킹

GPT-5와 GPT-5.1의 실제 성능을 비교하는 코드

import time

from openai import OpenAI

client = OpenAI()

def benchmark_model(model, prompt, iterations=3):

"""모델 성능 측정"""

times = []

tokens = []

for i in range(iterations):

start = time.time()

response = client.chat.completions.create(

model=model,

messages=[{"role": "user", "content": prompt}]

)

elapsed = time.time() - start

times.append(elapsed)

tokens.append(response.usage.total_tokens)

return {

"model": model,

"avg_time": sum(times) / len(times),

"avg_tokens": sum(tokens) / len(tokens),

"times": times

}

# 테스트 프롬프트

test_prompts = {

"간단한 작업": "2 + 2는?",

"중간 복잡도": "Python으로 피보나치 수열을 구현해줘",

"복잡한 작업": "디자인 패턴 중 Singleton, Factory, Observer의 차이를 실제 코드 예제와 함께 설명해줘"

}

# 벤치마크 실행

results = {}

for task_type, prompt in test_prompts.items():

print(f"\n{'='*50}")

print(f"테스트: {task_type}")

print(f"{'='*50}")

# GPT-5.1 Instant

result_instant = benchmark_model("gpt-5.1-chat-latest", prompt)

print(f"\nGPT-5.1 Instant:")

print(f" 평균 응답 시간: {result_instant['avg_time']:.2f}초")

print(f" 평균 토큰 수: {result_instant['avg_tokens']:.0f}")

# GPT-5.1 Thinking (복잡한 작업일 때)

if task_type == "복잡한 작업":

result_thinking = benchmark_model("gpt-5.1", prompt)

print(f"\nGPT-5.1 Thinking:")

print(f" 평균 응답 시간: {result_thinking['avg_time']:.2f}초")

print(f" 평균 토큰 수: {result_thinking['avg_tokens']:.0f}")

results[task_type] = result_instant

# 결과 요약

print(f"\n{'='*50}")

print("벤치마크 요약")

print(f"{'='*50}")

for task_type, result in results.items():

print(f"{task_type}: {result['avg_time']:.2f}초")

디버깅 및 모니터링

import logging

from datetime import datetime

from openai import OpenAI

# 상세 로깅 설정

logging.basicConfig(

level=logging.DEBUG,

format='%(asctime)s - %(name)s - %(levelname)s - %(message)s',

handlers=[

logging.FileHandler('gpt51_debug.log'),

logging.StreamHandler()

]

)

logger = logging.getLogger(__name__)

client = OpenAI()

def debug_api_call(messages, model="gpt-5.1-chat-latest"):

"""디버깅 정보와 함께 API 호출"""

logger.info(f"API 호출 시작 - 모델: {model}")

logger.debug(f"메시지: {messages}")

try:

start_time = datetime.now()

response = client.chat.completions.create(

model=model,

messages=messages

)

end_time = datetime.now()

duration = (end_time - start_time).total_seconds()

# 상세 정보 로깅

logger.info(f"API 호출 성공 - 소요 시간: {duration:.2f}초")

logger.debug(f"응답 ID: {response.id}")

logger.debug(f"모델: {response.model}")

logger.debug(f"토큰 사용량: {response.usage.total_tokens}")

logger.debug(f" - 입력: {response.usage.prompt_tokens}")

logger.debug(f" - 출력: {response.usage.completion_tokens}")

# 비용 계산

cost = estimate_cost(

response.usage.prompt_tokens,

response.usage.completion_tokens

)

logger.info(f"예상 비용: ${cost['total_cost']:.6f}")

return response

except Exception as e:

logger.error(f"API 호출 실패: {str(e)}", exc_info=True)

raise

# 사용 예제

response = debug_api_call([

{"role": "user", "content": "Python 데코레이터 설명해줘"}

])

print(response.choices[0].message.content)

프로덕션 체크리스트

배포 전 필수 확인사항

| 항목 | 확인 내용 | 상태 |

|---|---|---|

| 보안 | API 키 환경 변수 관리, .gitignore 설정 | ☐ |

| 에러 처리 | Rate Limit, 네트워크 오류 재시도 로직 | ☐ |

| 비용 모니터링 | 토큰 카운팅, 비용 추적 시스템 | ☐ |

| 캐싱 | 시스템 프롬프트 캐싱 활용 | ☐ |

| 로깅 | 요청/응답 로깅, 에러 트래킹 | ☐ |

| 성능 | 비동기 처리, 스트리밍 응답 구현 | ☐ |

| 컨텍스트 관리 | 대화 히스토리 제한, 토큰 제한 준수 | ☐ |

| 테스트 | 단위 테스트, 통합 테스트, 부하 테스트 | ☐ |

마치며

GPT-5.1은 단순한 기술적 업그레이드를 넘어, 사용자 경험의 질적 향상에 초점을 맞춘 의미 있는 업데이트다. GPT-5가 강력한 '압도적인 두뇌'였다면, GPT-5.1은 그 두뇌를 상황에 맞게 가장 효율적으로 사용하는 '현명한 파트너'로 진화했다.

적응형 추론, 향상된 대화 능력, 그리고 개발자 친화적인 기술적 개선은 GPT-5.1을 실무에서 더욱 유용하게 만든다. 특히 듀얼 모드(Instant/Thinking)와 Auto 라우팅 시스템은 사용자가 복잡한 설정 없이도 최적의 성능을 경험할 수 있게 해준다.

이번 글에서 소개한 실전 예제 코드들은 프로덕션 환경에서 바로 활용할 수 있도록 에러 처리, 비용 모니터링, 성능 최적화 등을 모두 고려하여 작성되었다. 이를 기반으로 여러분만의 AI 애플리케이션을 구축해보길 바란다.

기술의 발전 속도가 빨라질수록 중요한 것은 '어떤 모델이 더 좋은가'가 아니라, '내 업무에 어떤 모델을 어떻게 배치할 것인가'다. GPT-5.1의 장점을 이해하고, 적재적소에 활용해보자.

자주 묻는 질문 ❓

핵심 요약 📝

- 환경 설정: python-dotenv로 API 키 안전하게 관리, tiktoken으로 비용 추적

- 스트리밍: 실시간 UI 업데이트로 사용자 경험 향상

- 함수 콜링: 20% 향상된 성능으로 외부 도구 통합

- 비동기 처리: 배치 작업 처리 시간 3배 단축

- 에러 처리: Exponential Backoff로 안정적인 서비스 제공

- 비용 최적화: 프롬프트 캐싱으로 최대 90% 절감

- 프로덕션: FastAPI 통합, 로깅, 모니터링 완비

📚 추가 참고 자료

- Chat Completions API | OpenAI - 공식 API 문서

- Function Calling | OpenAI - 함수 콜링 가이드

- Rate Limit Handling | OpenAI Cookbook - Rate Limit 처리 방법

- openai-python | GitHub - 공식 Python SDK

- Production Best Practices | OpenAI - 프로덕션 베스트 프랙티스

이상으로 GPT-5.1 실전 활용 가이드를 정리해보았다. 도움이 되셨다면 공감과 구독 부탁드린다!

'AI > ChatGTP(Codex)' 카테고리의 다른 글

| GPT Image 1.5 리뷰 - OpenAI '코드 레드' 전략의 결과물 (4배 속도, 20% 저렴, Disney 협업) (2) | 2025.12.17 |

|---|---|

| GPT 5.2 출시 - 무료 포토샵, AI 삼파전(GPT-5.2, Gemini 3,Claude Opus 4.5) 살펴보기, skills 등 (1) | 2025.12.12 |

| AI 브라우저 Atlas (OpenAI(CHAT GPT)의 AI 브라우저) 사용해보기 (2) | 2025.10.24 |

| Open AI Agent Builder 사용해보기 - 시각적 캔버스로 AI Agent 설계·평가·배포까지 한 번에 (3) | 2025.10.08 |

| ChatGPT + MCP 연동해 보기 (GTP5에 MCP 연결하기) (5) | 2025.09.24 |

당신이 좋아할만한 콘텐츠

-

GPT Image 1.5 리뷰 - OpenAI '코드 레드' 전략의 결과물 (4배 속도, 20% 저렴, Disney 협업) 2025.12.17

-

GPT 5.2 출시 - 무료 포토샵, AI 삼파전(GPT-5.2, Gemini 3,Claude Opus 4.5) 살펴보기, skills 등 2025.12.12

-

AI 브라우저 Atlas (OpenAI(CHAT GPT)의 AI 브라우저) 사용해보기 2025.10.24

-

Open AI Agent Builder 사용해보기 - 시각적 캔버스로 AI Agent 설계·평가·배포까지 한 번에 2025.10.08

소중한 공감 감사합니다