Gemini 3 Flash 출시 리뷰 - 벤치마크, 가격, 사용법 등(3배 빠르고 4배 저렴한 Google의 새 AI 모델 Gemini 3)

- -

안녕하세요. 갓대희 입니다.

오늘은 Google Gemini3 Flash 에 대해 리뷰해보려고 한다.

2025년 12월 17일, Google이 Gemini 3 Flash를 공식 출시했다. 이 모델은 Gemini 3 Pro 수준의 추론 능력을 갖추면서도 3배 빠른 속도와 약 1/4 수준의 비용을 제공한다. Gemini 앱에서는 기본 모델로 설정되어 무료로 사용할 수 있으며, API를 통해 개발자들도 즉시 활용할 수 있다.

Google이 AI 모델의 새로운 기준을 제시했다. 2025년 12월 17일 발표된 Gemini 3 Flash는 "Pro급 추론 능력(Pro-grade reasoning)과 Flash급 지연시간, 효율성, 비용(Flash-level latency, efficiency and cost)"을 결합한 모델로, 성능과 비용 효율성 사이의 균형점을 새롭게 정의한다. 특히 코딩 벤치마크인 SWE-bench Verified에서 78%를 기록하며 상위 모델인 Gemini 3 Pro를 능가하는 결과를 보여줘 개발자 커뮤니티의 큰 관심을 받고 있다.

Gemini 3 Flash란?

Gemini 3 Flash는 Google DeepMind의 최신 Gemini 모델 라인업에서 "프론티어급 지능을 빠른 속도로(Frontier intelligence at speed)" 제공하도록 설계된 모델이다. 기존 Gemini 모델들이 성능(Pro)과 효율성(Flash-Lite) 중 하나를 선택해야 했다면, Gemini 3 Flash는 이 모든 한계를 허물고 품질, 비용, 속도 사이의 "파레토 최적 전선(Pareto Frontier)"을 새롭게 정의한다.

특히, 단순히 답변 속도가 빠른 것을 넘어 스스로 판단하고 도구를 사용하는 에이전틱 워크플로우(Agentic Workflows)에 가장 최적화된 모델로 설계되어, 개발자들이 더 지능적이고 반응이 빠른 AI 에이전트를 구축할 수 있게 돕는다.

Gemini 3 Flash의 핵심 포지셔닝

- Pro급 추론: 복잡한 문제 해결, 멀티모달 이해, 에이전틱 워크플로우 지원

- Flash급 속도: Gemini 2.5 Pro 대비 3배 빠른 응답 속도

- 비용 효율성: Gemini 3 Pro 대비 약 1/4 수준의 비용

- 토큰 효율성: Thinking Modulation 기술로 일반 작업 시 2.5 Pro 대비 평균 30% 적은 토큰 사용

- 에이전트 최적화: 복잡한 도구 사용과 멀티스텝 추론이 필요한 상황에 특화

기술 사양

| 항목 | Gemini 3 Flash |

|---|---|

| 최대 입력 토큰 | 1,048,576 토큰 (약 100만) |

| 최대 출력 토큰 | 65,536 토큰 |

| 지식 기준일 | 2025년 최신 정보 반영 (출시 직전까지) |

| 지원 입력 형식 | 텍스트, 이미지, 비디오, 오디오, PDF |

| 출력 형식 | 텍스트만 지원 |

Thinking 레벨 옵션

Gemini 3 Flash는 4단계 Thinking 레벨을 지원한다. 이는 Gemini 3 Pro의 2단계(low/high)보다 세분화된 옵션이다:

minimal- 가장 빠른 응답, 최소한의 추론low- 기본적인 추론medium- 균형 잡힌 추론high- 깊은 추론, 복잡한 문제에 적합

⚠️ 제한사항 및 참고사항

- 출력 형식: 현재 텍스트 출력만 지원한다. 이미지, 오디오 등의 멀티모달 출력은 불가능하다.

- 이미지 세그멘테이션: Gemini 2.5 Pro에서 지원하던 이미지 세그멘테이션 기능이 Gemini 3 Flash에서는 제거되었다.

- 프리뷰 상태: Gemini CLI에서 사용하려면 "Preview features"를 활성화해야 한다.

벤치마크 성능

Google 공식 발표에 따르면, Gemini 3 Flash는 주요 AI 벤치마크에서 다음과 같은 성능을 기록했다:

| 벤치마크 | Gemini 3 Flash | 벤치마크 설명 |

|---|---|---|

| GPQA Diamond | 90.4% | 대학원 수준의 과학 문제 해결 능력 평가 |

| Humanity's Last Exam | 33.7% | 인류 최고 난이도 시험 (전문가 수준) |

| MMMU Pro | 81.2% | 멀티모달(이미지+텍스트) 이해력 평가 |

| SWE-bench Verified | 78% | 실제 GitHub 이슈 해결 능력 (Pro 76.2% 능가) |

출처: Google Blog - Gemini 3 Flash 발표 (2025년 12월 17일)

경쟁 모델 비교 (Google DeepMind 발표)

아래 벤치마크는 Google DeepMind 공식 발표 데이터다. 모든 AI 회사가 자사 모델에 유리한 벤치마크를 선별하여 발표하는 경향이 있으므로, 독립 벤치마크(LM Arena 등)와 함께 참고하자.

| 벤치마크 | Gemini 3 Flash | Gemini 3 Pro | Claude Sonnet 4.5 | GPT-5.2 | Grok 4.1 |

|---|---|---|---|---|---|

| Humanity's Last Exam 최고 난이도 추론 |

33.7% | 37.7% | 24.8% | 26.4% | 23.4% |

| GPQA Diamond 대학원 수준 과학 |

90.4% | 88.5% | 79.1% | 80.7% | 82.1% |

| AIME 2025 수학 경시대회 |

92.6% | 93.0% | 77.3% | 78.0% | 83.3% |

| SWE-bench Verified 실제 코딩 문제 |

78.0% | 76.2% | 76.6% | 72.0% | 68.5% |

| LiveCodeBench Pro 실시간 코딩 평가 |

73.9% | 76.7% | 63.1% | 69.9% | 67.9% |

| MMMU-Pro 멀티모달 이해 |

81.2% | 82.1% | 70.3% | 73.1% | - |

| ARC-AGI-2 시각적 추론 |

21.5% | 31.3% | 14.5% | 14.0% | 8.0% |

출처: Google DeepMind - Gemini Models (2025년 12월)

⚠️ 위 수치는 Google 발표 기준이다. 실제 성능은 사용 환경과 프롬프트에 따라 달라질 수 있다. 독립적인 검증을 위해 LM Arena 등 제3자 벤치마크도 참고하자.

이건 Google DeepMind에서 발표한 벤치마크 표를 번역 한 것 이다. 참고로만 보자( Claude Opus를 빼버리다니................................................. ㅎㅎ )

SWE-bench Verified는 실제 GitHub 오픈소스 프로젝트의 이슈를 해결하는 능력을 측정하는 벤치마크다. Gemini 3 Flash(78%)가 상위 모델인 Gemini 3 Pro(76.2%)를 능가한다는 점은 코딩 작업에서 Flash 모델이 특히 최적화되어 있음을 시사한다.

가격 및 효율성

| 항목 | Gemini 3 Flash | 비고 |

|---|---|---|

| 입력 토큰 가격 | $0.50 / 1M 토큰 | 백만 토큰당 약 650원 (환율 1,300원 기준) |

| 출력 토큰 가격 | $3 / 1M 토큰 | 백만 토큰당 약 3,900원 (환율 1,300원 기준) |

| vs Gemini 3 Pro 비용 | ~1/4 수준 | 공식 발표 기준 |

| 토큰 효율성 | 30% 감소 | 일반 작업 기준, vs Gemini 2.5 Pro |

| 속도 | 3배 빠름 | vs Gemini 2.5 Pro |

| 오디오 입력 가격 | $1 / 1M 토큰 | 백만 토큰당 약 1,300원 |

| 대용량 컨텍스트 할인 | 1/8 가격 | >200K 토큰 사용 시 (vs Pro) |

출처: Google Blog - Gemini 3 Flash 발표 (2025년 12월 17일)

사용 가능한 플랫폼

개발자용 플랫폼

- Gemini API (Google AI Studio) - 웹 기반 API 테스트 및 프로토타이핑

- Google Antigravity - 2025년 11월 발표된 에이전틱 IDE 플랫폼. AI 에이전트가 자율적으로 코딩 작업을 수행할 수 있는 환경 제공

- Gemini CLI - 터미널 기반 AI 코딩 어시스턴트

- Android Studio - Android 개발 환경 통합

- Vertex AI & Gemini Enterprise - 기업용 클라우드 AI 플랫폼

일반 사용자용 플랫폼

- Gemini 앱 - 기본 모델로 설정됨 (무료 사용 가능)

- AI Mode in Search - Google 검색의 AI 모드 (전 세계 롤아웃 중)

개발자를 위한 시작 가이드

Gemini CLI 설치 및 설정

npm install -g @google/gemini-cli@latest설정 방법

/settings명령어로 설정 메뉴에 진입하자- "Preview features" 옵션을 활성화하자

/model명령어로 Gemini 3 Flash를 선택하면 된다

접근 권한 요구사항

Google 개발자 블로그에 따르면, 다음 조건 중 하나를 충족해야 Gemini 3 Flash에 접근할 수 있다:

| 사용자 유형 | 접근 조건 |

|---|---|

| Google AI Pro/Ultra 구독자 | 비업무용(Personal) 고객 |

| 유료 API 사용자 | Google AI 또는 Vertex AI 유료 API 키 보유자 |

| Gemini Code Assist 사용자 | 클라우드 관리자로부터 승인받은 사용자 |

| 무료 사용자 | 대기 목록(Waitlist) 등록 후 승인 필요 |

출처: Google Developers Blog - Gemini 3 Flash in Gemini CLI

Gemini 3 모델 패밀리

Gemini 3 Flash 출시로 Gemini 3 모델 패밀리가 완성되었다: Gemini 3 Pro (최고 성능), Gemini 3 Deep Think (심층 추론), 그리고 Gemini 3 Flash (속도 + 효율성).

Google DeepMind의 현재 Gemini 모델 라인업은 세 가지 주요 모델로 구성된다:

| 모델 | 포지셔닝 | 최적 사용 사례 |

|---|---|---|

| Gemini 3 Pro | 최고 성능 | 복잡한 작업, 창의적 개념 구현, 고급 추론 |

| Gemini 3 Flash | 성능 + 속도 균형 | 프론티어급 지능이 필요하면서 빠른 응답이 중요한 작업 |

| Gemini 2.5 Flash-Lite | 비용 효율성 | 대량 처리, 비용 효율적 작업, 단순 반복 작업 |

🔄 자동 라우팅 기능

Gemini 3 Flash는 자동 라우팅(Auto Routing) 기능을 지원한다. 이 기능은 작업의 복잡도에 따라 적절한 모델을 자동으로 선택한다:

- 복잡한 작업 → Gemini 3 Pro로 자동 할당

- 일상적인 작업 → Gemini 3 Flash로 자동 할당

경쟁사 모델 비교 (LM Arena 기준)

LM Arena는 사용자들이 익명으로 AI 모델을 비교 평가하는 대표적인 벤치마크 플랫폼이다. 2025년 12월 기준, 주요 모델들의 순위와 가격을 비교해보자.

| 모델 | LM Arena ELO | 입력 가격 (1M 토큰) | 출력 가격 (1M 토큰) |

|---|---|---|---|

| Gemini 3 Pro | ~1492 | $2 | $12 |

| Gemini 3 Flash | ~1490+ | $0.50 | $3 |

| Grok 4.1 Thinking | ~1484 🥈 | $3 | $15 |

| Claude Opus 4.5 | WebDev 1519 | $5 | $25 |

| GPT-5.2 | Preliminary | ~$1.75 | ~$14 |

• vs Claude Opus 4.5: 입력 가격 1/10 수준 ($0.50 vs $5)

• vs GPT-5.2: 입력 가격 약 1/3.5 수준 ($0.50 vs ~$1.75)

• vs Gemini 3 Pro: 입력 가격 1/4 수준이면서 코딩(SWE-bench)에서는 오히려 우수

• Text Arena 기준 상위권 성능을 최저 가격대로 제공

출처: LM Arena Leaderboard (2025년 12월 기준), Fello AI, Fiercefalcon Tracker

⚠️ ELO 점수는 실시간으로 변동된다. GPT-5.2는 12/11 출시로 아직 Preliminary 상태이며, Gemini 3 Flash는 현재 LM Arena에서 "Fiercefalcon"이라는 코드명으로 익명 테스트를 거치며 압도적인 성능을 증명하고 있는 것으로 알려져 있다. Claude Opus 4.5는 WebDev Arena 기준 점수이다.

공식 문서에서 언급된 활용 사례

Google 개발자 블로그에서는 Gemini 3 Flash의 실제 활용 사례로 다음을 언급했다:

- 대규모 Pull Request 처리: 1,000개 이상의 댓글이 포함된 대규모 PR 분석 및 리뷰

- 비동기 기반 로드 테스트 스크립트 생성: 복잡한 부하 테스트 코드 자동 생성

- 3D 그래픽 애플리케이션 코드 생성: 시각적 요소가 포함된 복잡한 애플리케이션 개발

속도를 활용한 추가 활용 시나리오

- Vibe Coding: 코드 작성 → 즉시 실행 → 수정을 빠르게 반복하는 개발 스타일. Flash의 초고속 응답 덕분에 피드백 루프가 크게 단축되어, 실시간 이터레이션 기반 개발에 최적화되어 있다.

- 에이전트/Computer Use 작업: 화면 캡처 → 분석 → 액션 수행이 필요한 에이전트 워크플로우에서, Flash의 빠른 응답 속도는 사용자 대기 시간을 획기적으로 줄여준다.

- 실시간 시뮬레이션 생성: 유튜브 테스트 영상에 따르면, 3D Terrain & Weather 앱 생성 시 Pro 대비 약 3배 빠른 속도(15초 vs 67초)를 보여줬다.

Gemini 3 출시 후 반응 및 기업 도입 사례

Google 공식 블로그에 따르면, Gemini 3 시리즈는 출시 이후 엄청난 반응을 얻고 있다:

출시 후 반응

- 하루 1조(1T) 토큰 이상 처리 중: Gemini 3 Pro 및 Deep Think 출시 이후 API에서 매일 1조 개 이상의 토큰을 처리하고 있다

- 다양한 활용 사례: 복잡한 주제 학습을 위한 시뮬레이션 코딩(Vibe Coding), 인터랙티브 게임 빌드 및 디자인, 다양한 멀티모달 콘텐츠 이해 등

실제 기업 도입 사례

Google은 이미 주요 기업들이 Gemini 3 Flash를 도입하여 비즈니스를 혁신하고 있다고 발표했다:

- JetBrains: IntelliJ IDEA 등 개발 도구에 AI 기능 통합

- Bridgewater Associates: 세계 최대 헤지펀드에서 분석 및 의사결정 지원

- Figma: 디자인 협업 플랫폼에서 AI 기반 기능 강화

이들 기업은 Flash의 추론 속도, 효율성, 그리고 대형 모델에 버금가는 추론 능력을 높이 평가하고 있다.

일반 사용자를 위한 활용 사례

Gemini 3 Flash는 이제 Gemini 앱에서 기존 2.5 Flash를 대체하여 기본 모델로 설정되었다. 전 세계 모든 Gemini 사용자가 무료로 Gemini 3급 경험을 할 수 있게 된 것이다:

공식 데모 영상으로 보는 활용 사례

골프 스윙 분석: 짧은 비디오를 분석하고 개선 계획을 제공 - [데모 영상]

실시간 그림 맞추기: 스케치하는 동안 그림을 보고 실시간으로 추측 - [데모 영상]

오디오 학습 도우미: 오디오 녹음을 업로드하면 지식 갭을 식별하고, 맞춤형 퀴즈를 생성하며, 상세한 해설 제공 - [데모 영상]

음성으로 앱 만들기: 코딩 지식 없이도 음성으로 지시하면 몇 분 만에 작동하는 앱을 생성

개발자를 위한 고급 데모

인게임 AI 어시스턴트: 핸드 트래킹 기반 퍼즐 게임에서 실시간 AI 도움 제공 - [데모 영상]

실시간 A/B 테스트: 로딩 스피너 디자인을 실시간으로 빌드하고 A/B 테스트 - [데모 영상]

이미지 인터랙티브 변환: 정적 이미지를 분석하고 컨텍스트 UI 오버레이로 인터랙티브 경험으로 변환 - [데모 영상]

디자인 변형 생성: 하나의 프롬프트로 세 가지 고유한 디자인 변형을 코딩 - [데모 영상]

Gemini 3 Flash는 Google 검색의 AI Mode에서도 기본 모델로 롤아웃 중이다. Gemini 3 Pro의 추론 능력을 기반으로, 질문의 뉘앙스를 더 잘 파악하고, 실시간 로컬 정보와 웹 링크를 포함한 시각적으로 정리된 응답을 검색 속도로 제공한다. 특히 복잡한 여행 계획이나 교육 개념 학습에 유용하다.

자주 묻는 질문 ❓

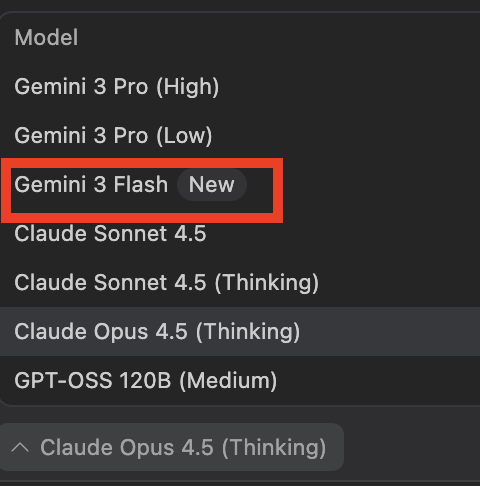

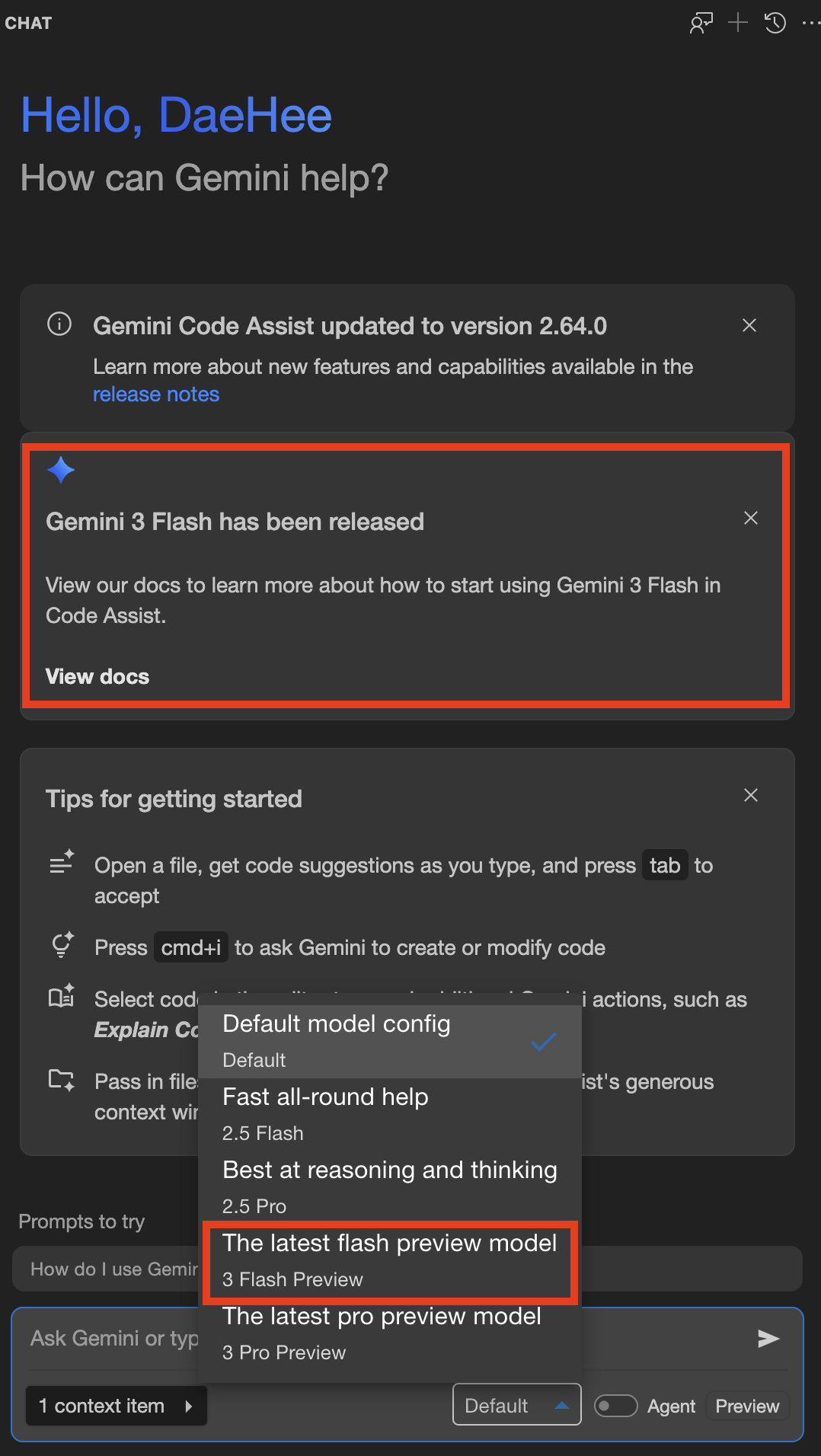

ex) 안티 그래비티 에서도 다음과 같이 신규 모델 관련 안내가 되고 있고, 바로 사용 가능 하다.

ex) gemini code assist

npm install -g @google/gemini-cli@latest로 설치 후, /settings에서 "Preview features"를 활성화하고 /model 명령어로 Gemini 3 Flash를 선택하면 된다.참고 자료

- Google Blog - Gemini 3 Flash 공식 발표 - 출시 발표 및 주요 특징

- Google Developers Blog - Gemini CLI에서 Gemini 3 Flash 사용하기 - 개발자 가이드

- Google DeepMind - Gemini 모델 라인업 - 모델 비교 및 개요

- Gemini CLI 공식 문서 - CLI 사용 가이드

- Google AI for Developers - API 및 개발자 리소스

- Artificial Analysis - Gemini 3 Flash 벤치마크 - 속도 3배 빠름 검증 출처

- [공식 데모] Gemini 3 Flash vs 2.5 Pro 속도/품질 비교 - Google 공식 비교 영상

- Google Blog - Gemini 앱에서 Gemini 3 Flash - 앱 사용자용 가이드

- Google Blog - AI Mode in Search 업데이트 - 검색 AI Mode 롤아웃 안내

- Google Cloud Blog - 기업용 Gemini 3 Flash - Vertex AI 및 Gemini Enterprise 가이드

- Google Developers - Build with Gemini 3 Flash - 개발자용 상세 가이드

- Simon Willison - Gemini 3 Flash 분석 - 독립적인 기술 분석 및 상세 사양

- [YouTube] Gemini 3 Flash Is INSANE – Testing Google's FASTEST Model! - Bijan Bowen 실제 테스트

- [YouTube] Google just dropped Gemini 3 FLASH! - 심층 분석 및 벤치마크 비교

마무리

Gemini 3 Flash의 출시로 Google의 Gemini 3 모델 패밀리가 완성되었다: Gemini 3 Pro (최고 성능), Gemini 3 Deep Think (심층 추론), 그리고 Gemini 3 Flash (속도 + 효율성).

Gemini 3 Flash는 Google이 제시하는 "성능과 효율성의 새로운 균형점"이다.

Pro급 추론 능력, Flash급 속도와 비용을 동시에 원하는 개발자와 기업에게 매력적인 선택지가 될 것으로 보인다.

특히 SWE-bench에서 Pro를 능가하는 코딩 성능은 개발자 워크플로우에서 Flash 모델의 가치를 더욱 높여준다.

JetBrains, Bridgewater Associates, Figma 같은 글로벌 기업들이 이미 Gemini 3 Flash를 도입하여 비즈니스를 혁신하고 있다. Google은 "우리는 여러분이 이 확장된 모델 패밀리로 무엇을 만들어낼지 기대하고 있다"며 개발자와 사용자들의 창의적인 활용을 기대했다.

'AI > Gemini' 카테고리의 다른 글

당신이 좋아할만한 콘텐츠

-

Gemini 3.1 Pro 출시 리뷰 : 신규 기능, 벤치마크 등(3 Pro 대비 2배 강력해진 추론 능력) 2026.02.21

-

Gemini 3 Deep Think 살펴보기 - Google의 병렬 추론 AI, 언제 어떤 모드를 사용해야 할까? 2025.12.11

-

Antigravity 보안 설정 : 보안 취약점 원인 및 해결방법 - AI 코딩 도구의 숨겨진 위협과 방어 전략(프롬프트 인젝션부, 백도어 등) 2025.12.10

-

Google Workspace Studio 사용해보기 - Gemini 3 기반 노코드 AI 에이전트 플랫폼 2025.12.08

소중한 공감 감사합니다