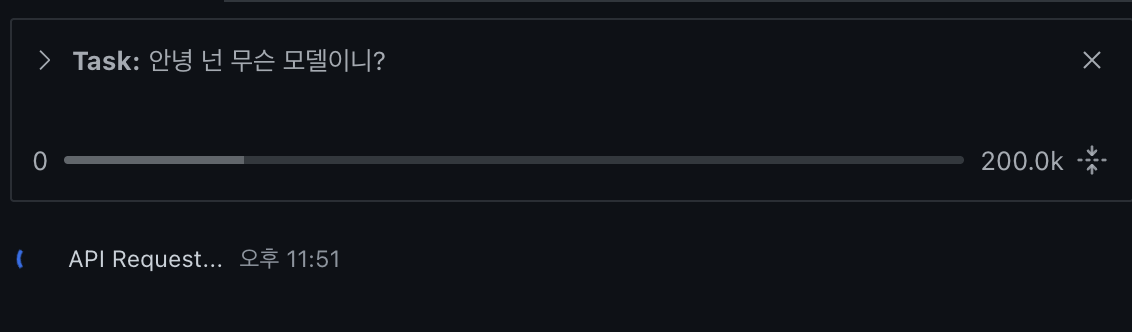

Open Code 리뷰(4) : OpenCode(oh-my-opencode)에 Z.ai GLM 연동하기(with claude code Z.aiGLM연동)

- -

안녕하세요! 갓대희 입니다.

최근 AI 코딩 도구 비용이 부담되시는 분들이 선택하는 Plan-B(대안) 정도를 정리해 보았다.

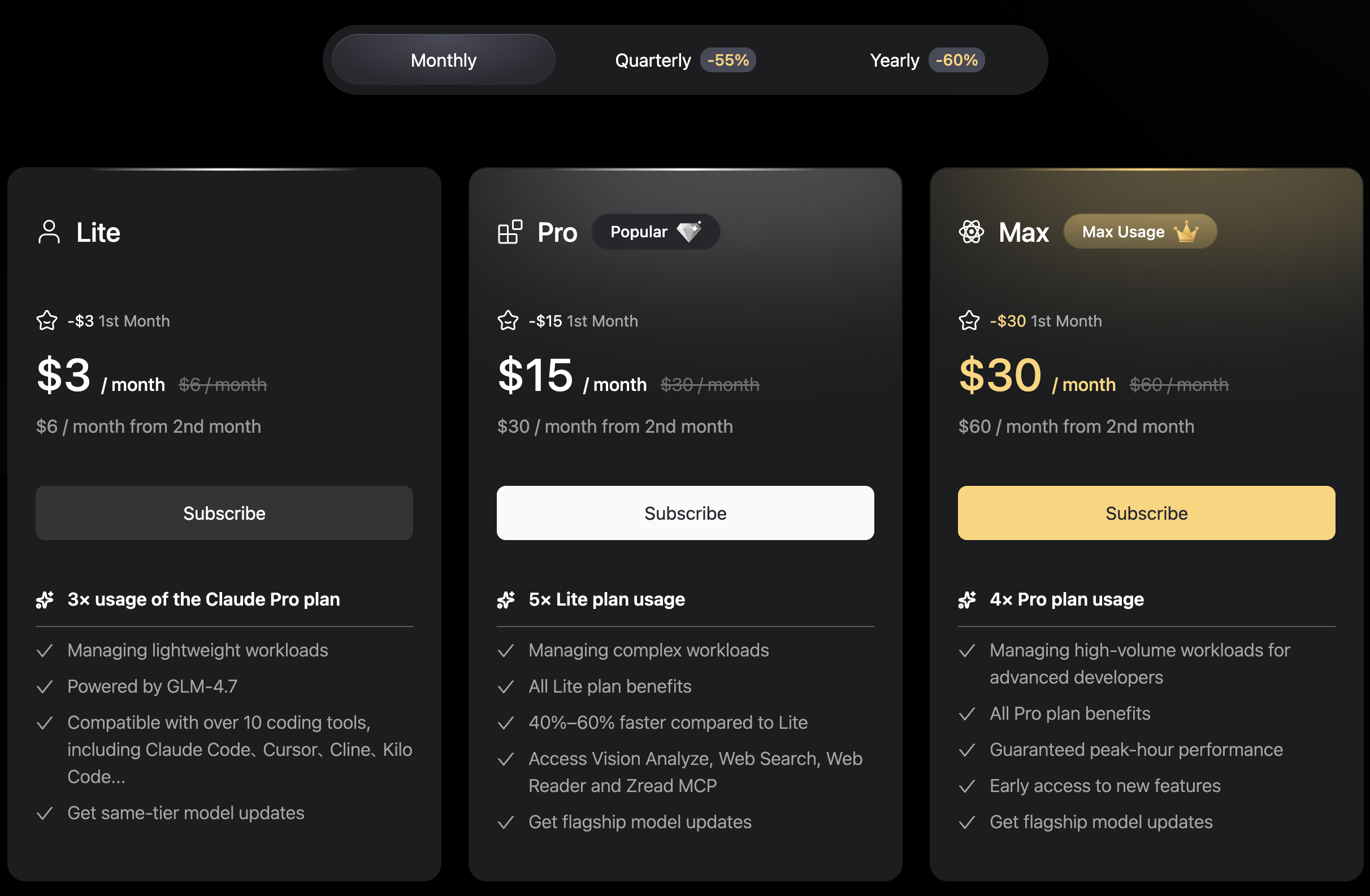

Z.ai (구 Zhipu AI)에서 제공하는 GLM 모델 시리즈가 Claude Code나 OpenCode(Oh-my-OpenCode)와 연동하여 사용할 수 있고, 특히 Coding Plan은 월 $6부터 시작해서 가성비가 매우 뛰어나다. (첫 달 50% 할인 시 $3)

- 무료 모델: GLM-4.5-Flash, GLM-4.6V-Flash

- Coding Plan: 월 $6(첫 달 $3)로 5시간당 120 프롬프트

- Context Caching: 입력 비용 80% 절감

- Thinking Mode: 고급 추론 기능

- Claude Code / OpenCode 연동: 설정 방법 상세 가이드

이 글은 OpenCode의 기본 사용법을 알고 있다는 전제하에 작성되었다. (claude code는 기본) OpenCode가 처음이라면 먼저 Part 1: OpenCode 기초를 읽어보길 권한다.

이 글의 정보는 2026년 1월 기준입니다. 가격, 모델, 기능은 변경될 수 있으므로, 적용 전 공식 사이트에서 최신 정보를 확인하세요.

목차

1. Z.ai란? 왜 주목받는가

Z.ai (구 Zhipu AI)는 베이징에 본사를 둔 중국 AI 기업으로, 2025년에 리브랜딩되었다. 중국 LLM 시장에서 3위를 차지하며 "AI Tiger" 기업 중 하나로 꼽힌다.

왜 Z.ai가 핫한가?

Claude Max Plan 구독이 월 $100~$200인 반면, Z.ai Coding Plan은 월 $6부터 시작한다. (첫 달 50% 할인 시 $3)

API 종량제 기준으로도 Claude/GPT 대비 4~7배 저렴하면서 유사한 성능을 보여준다.

| 구분 | Claude Pro | Claude Max Plan | Z.ai Coding Lite |

|---|---|---|---|

| 월 요금 | $20 | $100~$200 | $6 (첫 달 $3) |

| 5시간당 사용량 | ~45개 | 약 225~900개 (Pro의 5~20배) |

120개 |

| 컨텍스트 윈도우(한 번에 처리 가능한 텍스트 길이) | 200K | 200K | 200K |

작년(2025년) 1월, 미국 상무부는 국가 안보 우려로 Z.ai를 Entity List(미국 수출 제한 대상 목록)에 등재했다. 이는 객관적 사실이며, 서비스 이용 여부는 각자 판단에 맡긴다. (출처: Wikipedia)

2. GLM 모델 라인업

Z.ai는 다양한 GLM 모델을 제공한다. 2026년 1월 기준 주요 모델은 다음과 같다:

최신 모델 (GLM-4.x 시리즈)

| 모델 | 파라미터(모델 크기) | 컨텍스트 | 특징 | 가격 |

|---|---|---|---|---|

| GLM-4.7 | 355B (32B 활성) | 200K | 최신 코딩 특화, MoE 아키텍처(Mixture of Experts, 여러 전문가 모델 중 적합한 것만 활성화하는 방식) | $0.6/$2.2 |

| GLM-4.6 | - | 200K | 에이전트(자동 작업 수행)/추론 강화 | $0.6/$2.2 |

| GLM-4.6V | 106B | 128K | 멀티모달(텍스트+이미지 처리) | $0.3/$0.9 |

| GLM-4.5 | 355B (32B 활성) | 128K | 범용, 추론/코딩/에이전트 통합 | $0.6/$2.2 |

| GLM-4.5-Air | 106B (12B 활성) | 128K | 경량화 버전, 가성비 | $0.2/$1.1 |

| GLM-4.5-Flash | - | 128K | 무료! 빠른 응답 | 무료 |

| GLM-4.6V-Flash | - | - | 무료! 멀티모달(텍스트+이미지 처리) | 무료 |

| GLM-4.5V | - | 128K | GLM-4.5의 비전 버전 | $0.6/$1.8 |

| GLM-4.6V-FlashX | - | - | 저가 비전 모델, 빠른 응답 | $0.04/$0.4 |

| GLM-4-32B-0414 | 32B | 128K | 초저가! 가벼운 작업용 | $0.1/$0.1 |

GLM-4.5-Flash와 GLM-4.6V-Flash는 완전 무료로 제공된다.

간단한 작업이나 테스트 목적으로는 무료 모델만으로도 충분할 수 있다.

모델 선택 가이드

- 코딩 작업: GLM-4.7 (최신, 코딩 특화)

- 일반 대화/분석: GLM-4.5 또는 GLM-4.5-Air

- 이미지 분석: GLM-4.6V 또는 GLM-4.6V-Flash (무료)

- 비용 최소화: GLM-4.5-Flash (무료)

- 빠른 응답 필요: GLM-4.5-Flash (무료) 또는 GLM-4.5-Air

3. 가격 비교 (무료 모델 포함)

API 종량제(사용한 만큼만 지불) 가격 - 1M 토큰(약 75만 단어)당

| 모델 | 입력 | 캐시 입력 | 출력 |

|---|---|---|---|

| GLM-4.7 | $0.60 | $0.11 | $2.20 |

| GLM-4.6 | $0.60 | $0.11 | $2.20 |

| GLM-4.6V | $0.30 | $0.05 | $0.90 |

| GLM-4.5 | $0.60 | $0.11 | $2.20 |

| GLM-4.5-Air | $0.20 | $0.03 | $1.10 |

| GLM-4.5-Flash | 무료 | 무료 | 무료 |

| GLM-4.6V-Flash | 무료 | 무료 | 무료 |

(출처: Z.ai 공식 가격 문서)

캐시된 입력 토큰은 약 80% 저렴하다 ($0.60 → $0.11).

캐시 저장 비용은 현재 기간 한정 무료로 제공되고 있다.

4. Coding Plan 상세

Z.ai의 Coding Plan은 Claude Code, OpenCode, Cline 등 코딩 도구와 연동하여 사용할 수 있는 구독 서비스다.

플랜별 비교

| 플랜 | 정가 | 첫 달 할인가 | 5시간당 쿼터 | 특징 |

|---|---|---|---|---|

| Coding Lite | $6/월 | $3/월 | 120 prompts | 대부분의 개발자에게 적합 |

| Coding Pro | $30/월 | $15/월 | 600 prompts | 40% 빠른 응답, 이미지/비디오 입력 |

| Coding Max | ~$60/월 | - | ~2,400 prompts | Pro의 4배 사용량 |

(출처: Z.ai 구독 페이지) - 프로모션 가격은 변경될 수 있음

ex) 월간

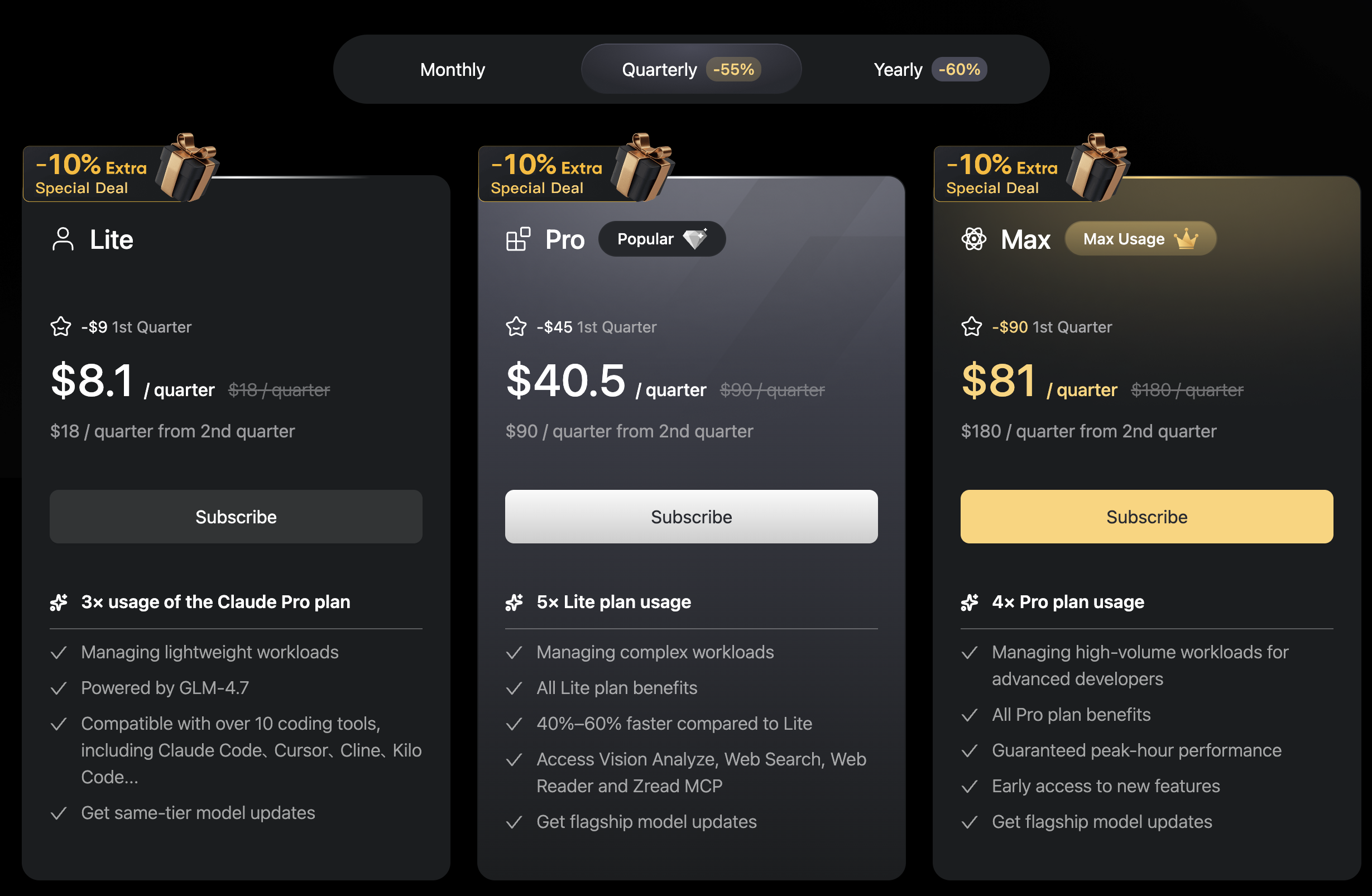

기간별 요금 플랜 (장기 결제 할인)

장기 결제(분기/연간) 이용 시 첫 결제 기간에 대해 파격적인 할인을 제공한다. 장기간 사용할 예정이라면 연간 결제가 가장 유리하다.

| 플랜 | 월간 (Monthly) (첫 달 50% 할인) |

분기별 (Quarterly) (첫 분기 약 55% 할인) |

연간 (Yearly) (첫 해 60% 할인) |

|---|---|---|---|

| Coding Lite | 첫 달 $3 (이후 $6/월) |

첫 분기 $8.1 (이후 $18/분기) |

첫 연 $28.8 (이후 $72/연) |

| Coding Pro | 첫 달 $15 (이후 $30/월) |

첫 분기 $40.5 (이후 $90/분기) |

첫 연 $144 (이후 $360/연) |

| Coding Max | 첫 달 $30 (이후 $60/월) |

첫 분기 $81 (이후 $180/분기) |

첫 연 $288 (이후 $720/연) |

- 첫 결제 파격 할인: 월간(50%), 분기(55%), 연간(60%) 등 첫 결제 주기에만 큰 폭의 할인이 적용된다.

- 갱신 시 정가 과금: 할인 기간 종료 후에는 정가(월 $6/$30/$60 기준)로 자동 갱신된다.

- 해지 타이밍: 할인가로 이용 후 자동 갱신을 원치 않는다면, 결제 주기 갱신 전에 해지해야 한다.

- 나의 경우 쿼터 요금제 / pro 요금제로 테스트 예정 이다.

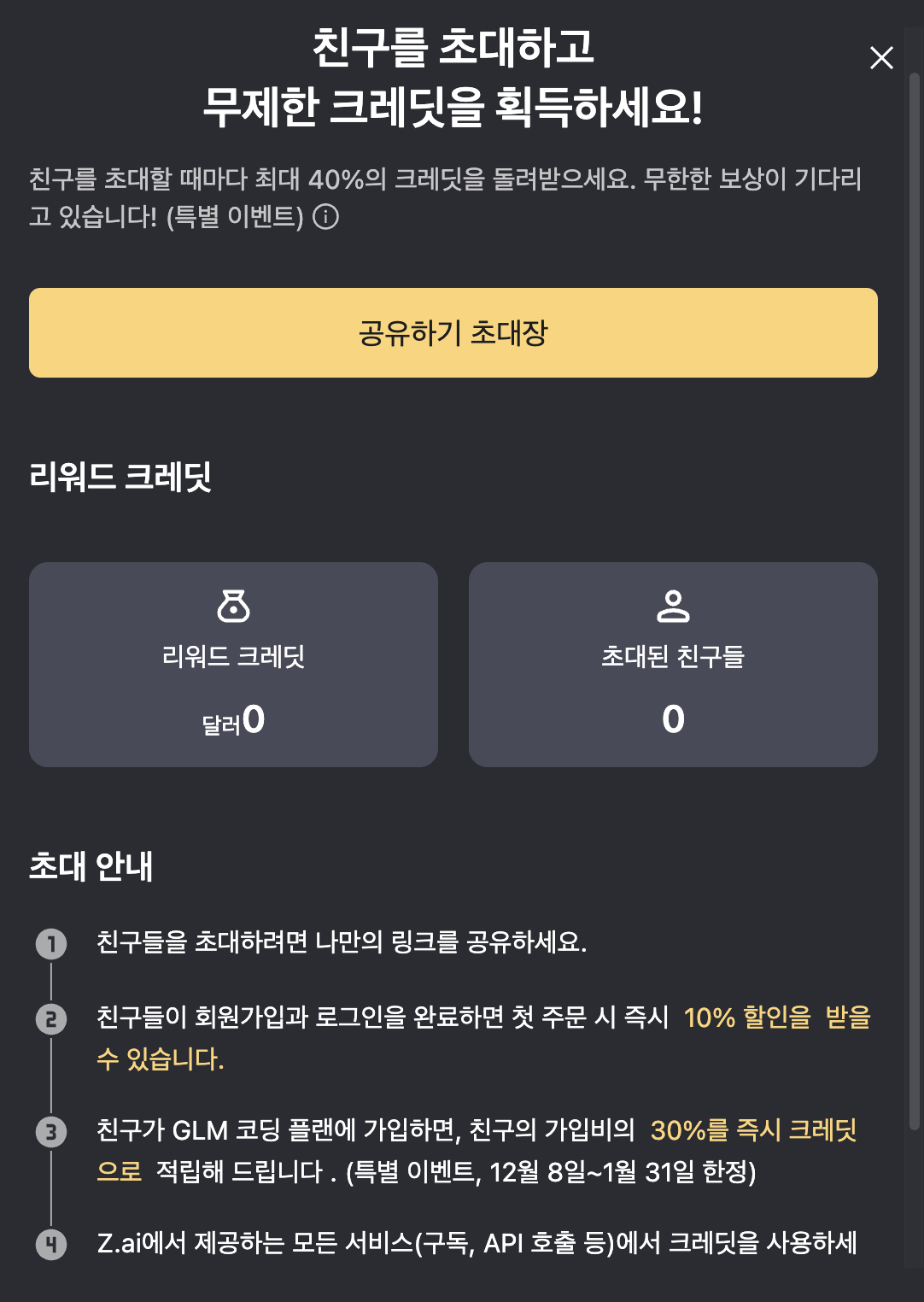

- 그리고 친구 링크를 타고 들어가면 추가 10% 할인된다고 하여 나도 링크 생성은 해보았다.

- 🚀 You’ve been invited to join the GLM Coding Plan! Enjoy full support for Claude Code, Cline, and 10+ top coding tools — starting at just $3/month. Subscribe now and grab the limited-time deal!

Link: https://z.ai/subscribe?ic=BVEF1AVEI0

ex) 분기별

ex) 연간

Coding Plan 포함 기능 - MCP Server(AI와 외부 서비스 연결)

Coding Plan에는 다음과 같은 MCP Server 기능(Model Context Protocol, AI가 외부 서비스와 소통하는 규약)이 포함되어 있다:

- Vision Understanding: 이미지 분석 및 이해 (Pro 플랜 이상)

- Web Search: 웹 검색 기능

- Web Reader: 웹 페이지 내용 읽기

5시간 주기 쿼터(할당량) 시스템

5시간 주기란?

- 쿼터 리셋: 매 5시간마다 프롬프트 쿼터가 자동으로 리셋된다

- 쿼터 소진 시: 다음 5시간 주기 시작 시 자동으로 복구된다

- 추가 과금 없음: 쿼터를 초과해도 별도 과금이 발생하지 않는다 (단, 사용 불가)

- 제한 사항: Coding Plan은 지원 도구(Claude Code, Cline 등)에서만 사용 가능하며, 직접 API 호출은 불가

Coding Lite의 5시간당 120 프롬프트는 하루 약 576개에 해당한다 (24시간 / 5시간 * 120).

일반적인 코딩 작업에는 충분한 양이다. 부족하다면 Pro 플랜을 고려하자.

Claude Pro 대비 비교

| 항목 | Claude Pro | Z.ai Coding Lite |

|---|---|---|

| 월 요금 | $20 | $3 |

| 5시간당 메시지 | ~45개 | 120개 |

| 가격당 메시지 | 2.25개/$1 | 40개/$1 |

| 모델 성능 | Claude 5 Sonnet | GLM-4.7 (~80% 수준) |

"GLM is really good at coding. For $3 a month, I already built 4 apps with it."

"It just seems to do what I want more reliably than other models, less reworking of prompts needed."

(출처: 커뮤니티 리뷰)

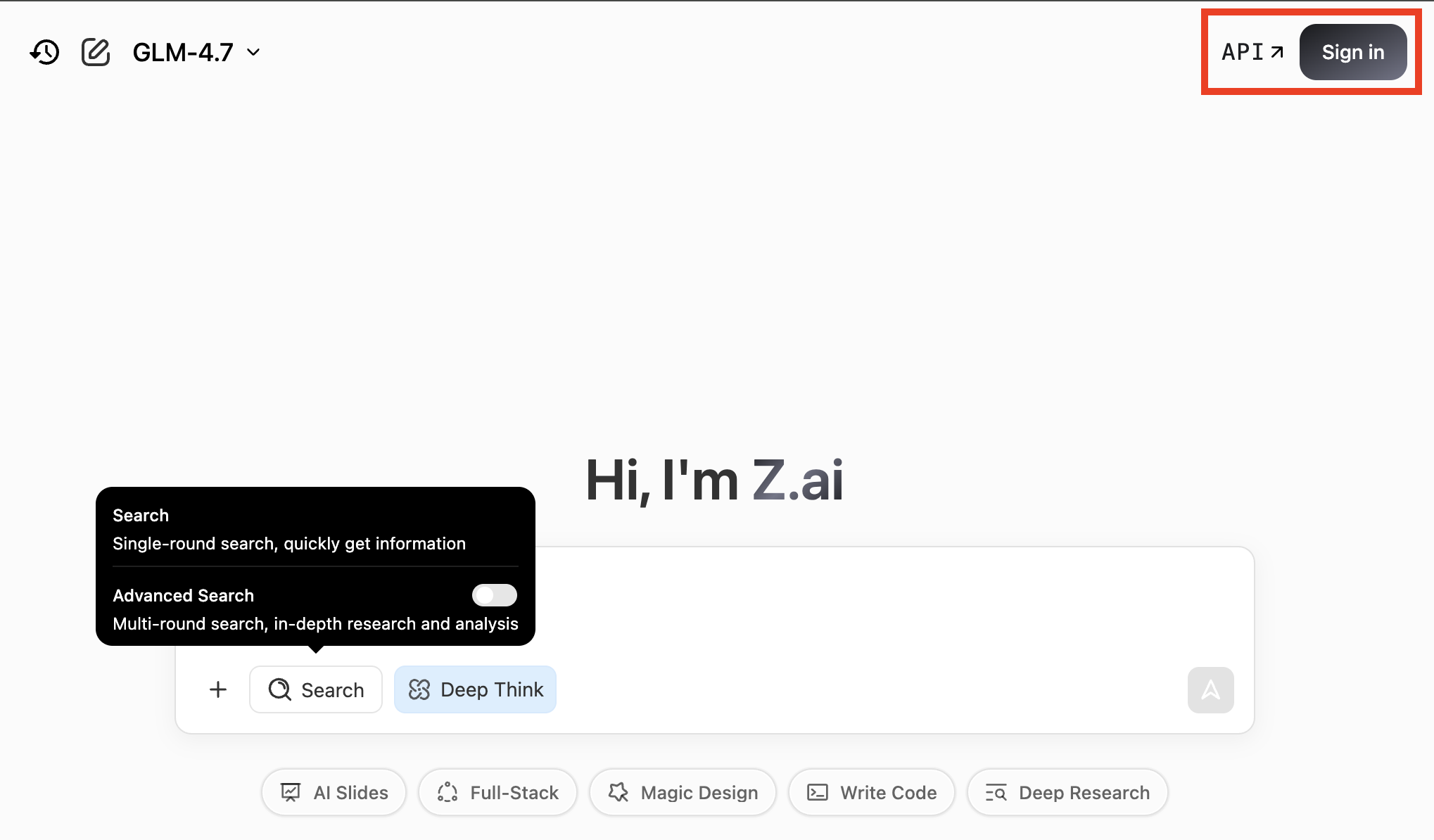

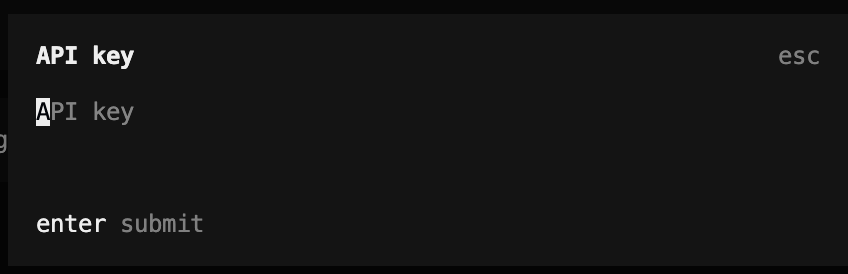

5. 가입 및 API 키 발급

Z.ai API를 사용하려면 계정을 만들고 API 키를 발급받아야 한다.

Step 1: 회원가입

1. https://z.ai 접속 또는 https://z.ai/subscribe

2. 우측 상단 "API" 또는 "로그인" 클릭

3. gmail, 이메일로 가입 선택 등 본인이 원하는 방법으로 회원 가입 진행(한국 이메일 사용 가능)

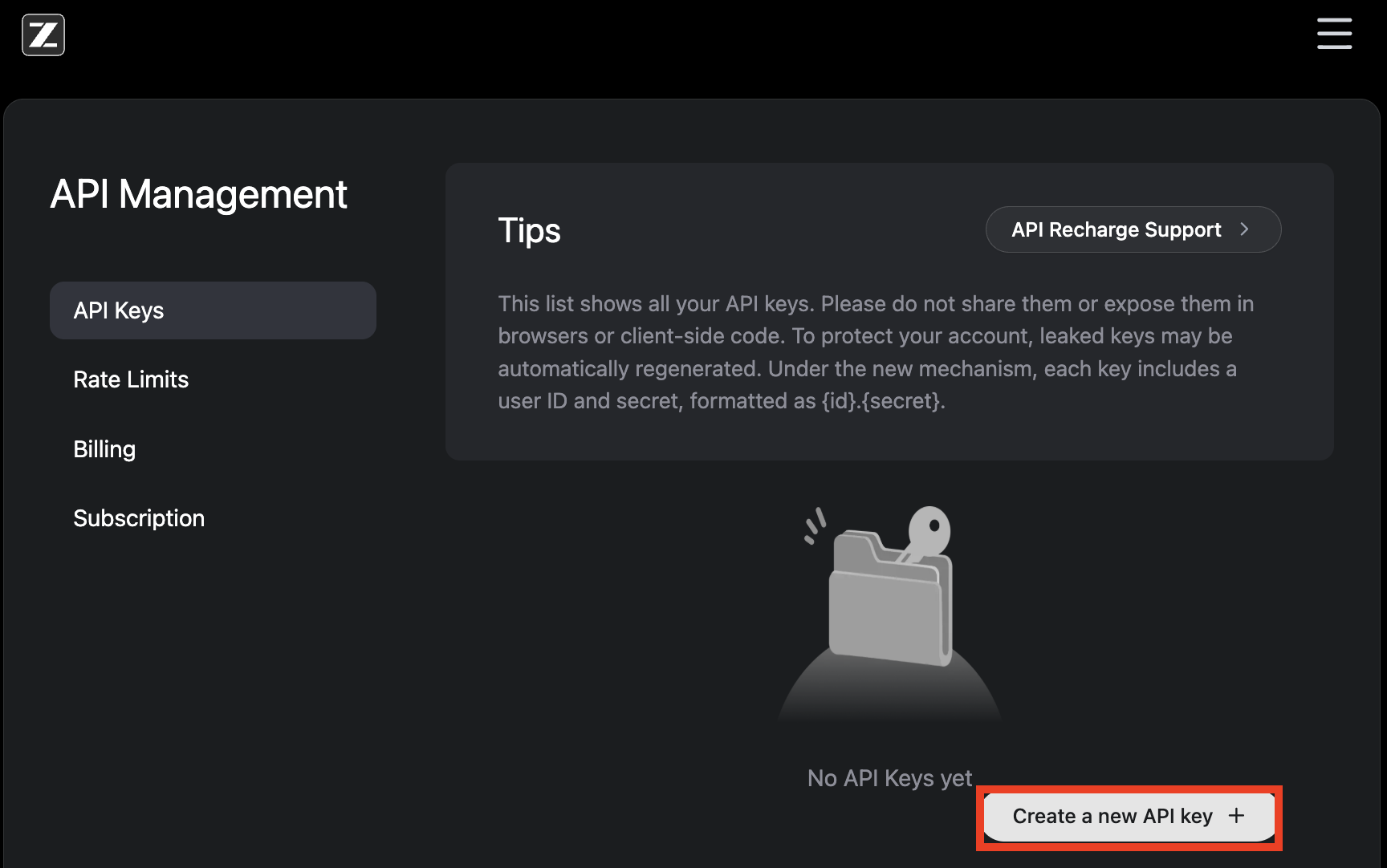

Step 2: API 키 발급

1. 로그인 후 "API" 또는 "콘솔" 메뉴 진입

2. 좌측 메뉴에서 "API Keys" 클릭

3. "Create API Key" 버튼 클릭

4. 생성된 API 키 복사 (한 번만 표시되므로 안전하게 저장)

export ZAI_API_KEY="your-api-key-here"

6. Claude Code 연동 설정

Z.ai GLM을 Claude Code에서 사용하려면 API 엔드포인트(API 접속 주소)와 모델 매핑을 설정해야 한다.

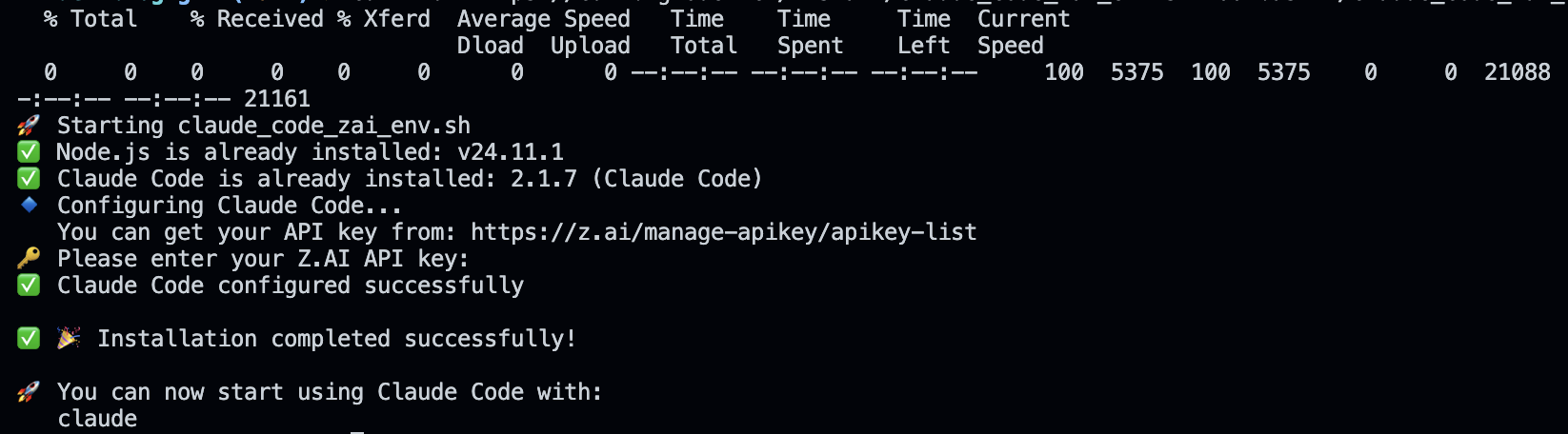

방법 1: 자동 설정 스크립트 (권장)

curl -O "https://cdn.bigmodel.cn/install/claude_code_zai_env.sh" && bash ./claude_code_zai_env.sh스크립트 실행 후 API 키를 입력하면 자동으로 설정이 완료된다. (혹시 1번 방법으로 잘 안되는 경우 : 방법 2로 세팅해 주자)

ex) 중간에 Z.ai API KEY 입력

방법 2: 수동 설정

~/.claude/settings.json 파일을 다음과 같이 수정한다:

{

"env": {

"ANTHROPIC_AUTH_TOKEN": "your_zai_api_key",

"ANTHROPIC_BASE_URL": "https://api.z.ai/api/anthropic",

"API_TIMEOUT_MS": "3000000",

"ANTHROPIC_DEFAULT_HAIKU_MODEL": "glm-4.5-air",

"ANTHROPIC_DEFAULT_SONNET_MODEL": "glm-4.7",

"ANTHROPIC_DEFAULT_OPUS_MODEL": "glm-4.7"

}

}

- 반대로 해당 내용을 제거하면 원복 된다.

ex) 제대로 변경 된 경우를 비교해보자.

- 변경전 Opus 4.5

- 변경 후 glm-4.7

Coding Plan 전용 엔드포인트

- 일반 API:

https://api.z.ai/api/paas/v4 - Coding Plan:

https://api.z.ai/api/coding/paas/v4 - Anthropic 호환:

https://api.z.ai/api/anthropic

방법 3: GLM CLI 도구

별도의 CLI 도구를 사용하여 더 편리하게 설정할 수도 있다:

curl -fsSL https://raw.githubusercontent.com/xqsit94/glm/main/install.sh | bash

# API 토큰 설정

glm token set

# GLM으로 Claude Code 실행

glm

트러블슈팅

버전 호환성

- Claude Code 2.0.14 이상 필요

- 이전 버전에서는 연동이 정상 작동하지 않을 수 있음

- 버전 확인:

claude --version

흔한 오류와 해결

| "Authorization Failure" | Coding Plan 엔드포인트 확인, API 키 재확인 |

| "Insufficient Balance" | Coding Plan이 아닌 일반 API 엔드포인트 사용 중일 수 있음 |

| "Timeout" / 응답 지연 | API_TIMEOUT_MS를 3000000 이상으로 설정 |

| 모델을 찾을 수 없음 | 모델명 정확히 입력 (예: glm-4.7, 대소문자 구분) |

settings.json에 모델명을 하드코딩하면 Z.ai에서 새 모델이 출시되어도 자동 업데이트되지 않는다.

최신 모델을 사용하려면 주기적으로 설정을 확인하고 업데이트하자.

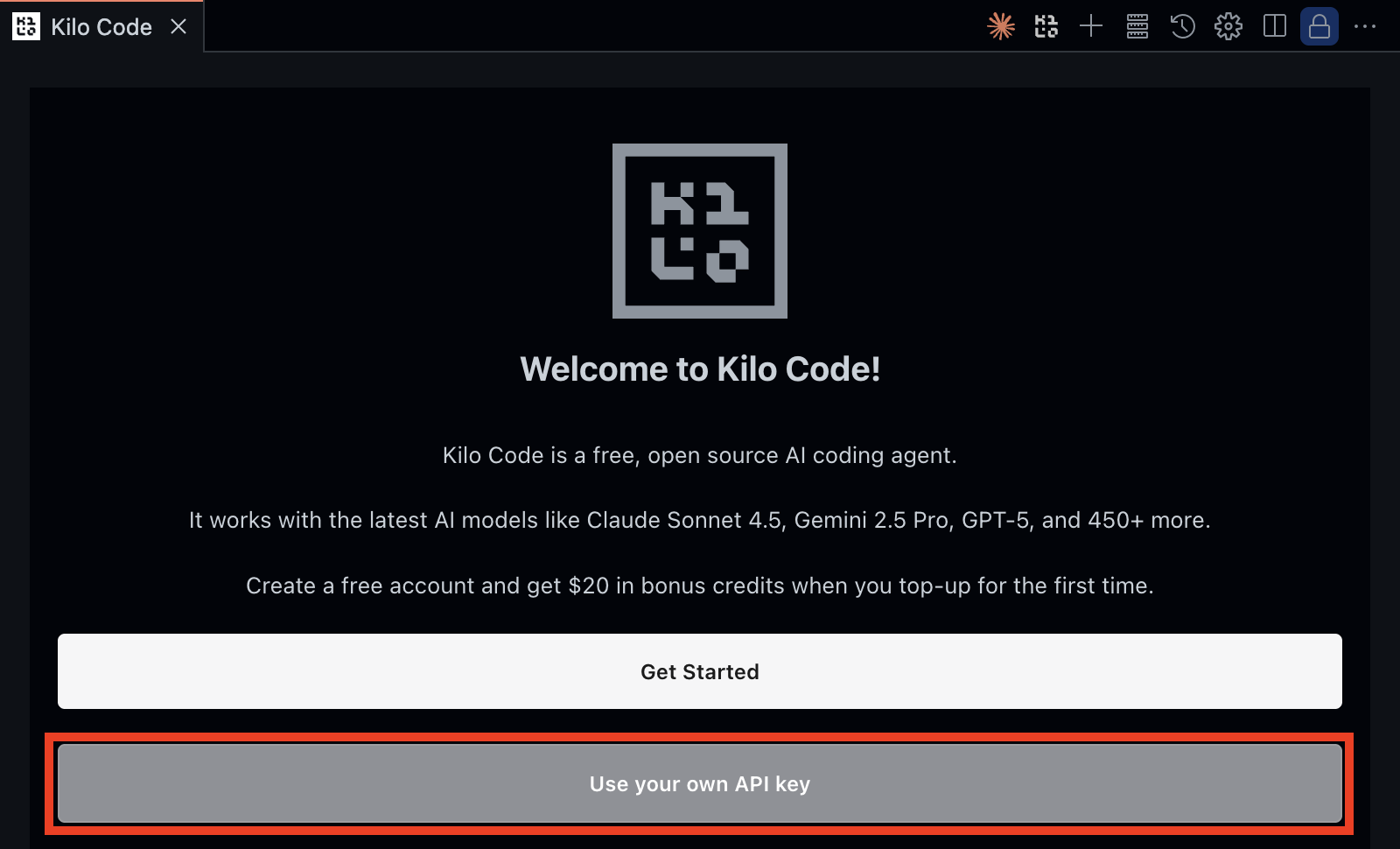

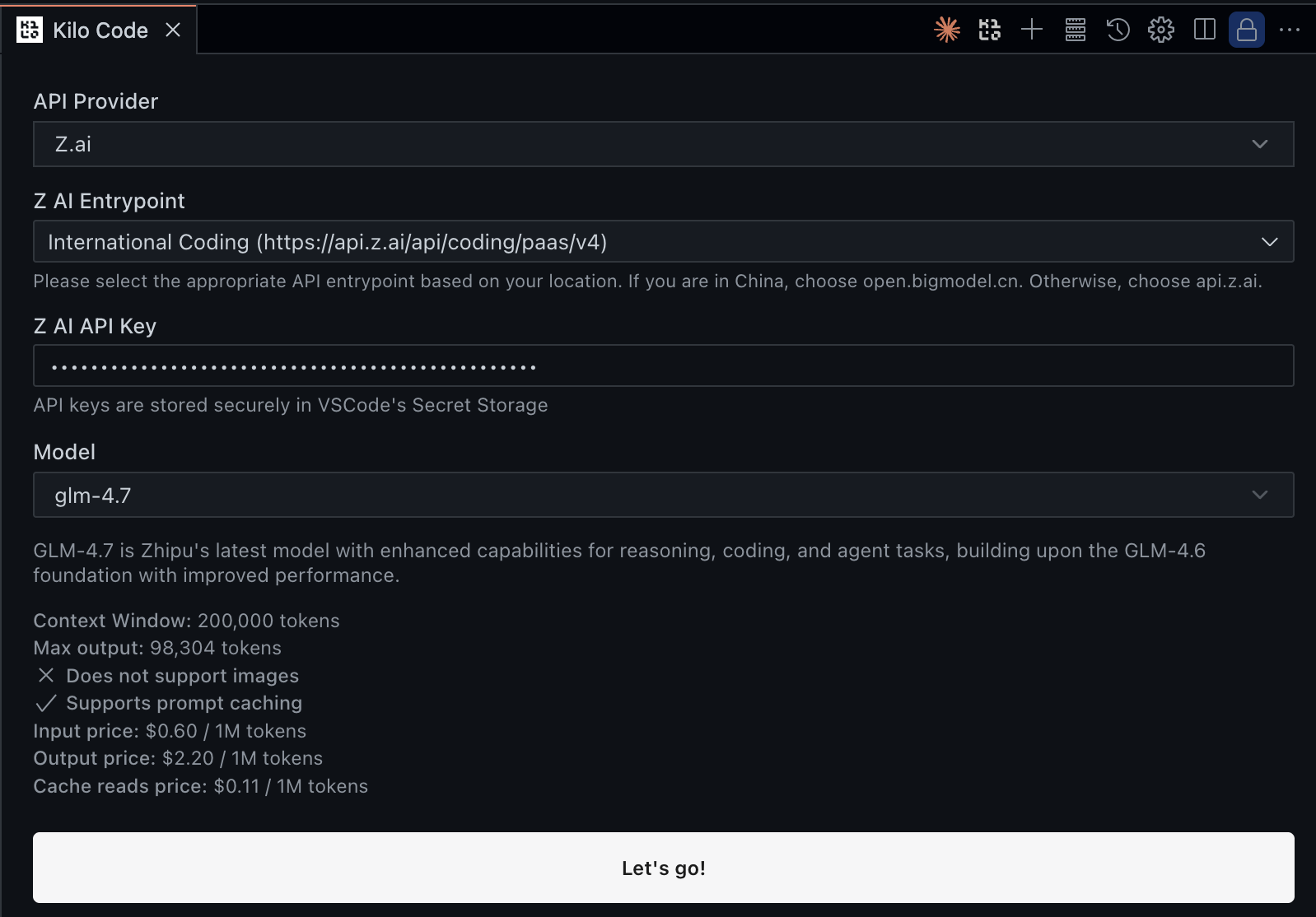

7. VS Code 확장 프로그램 연동 (Cline, Kilo)

VS Code에서 가장 인기 있는 AI 코딩 에이전트인 Cline과 Kilo에서도 Z.ai GLM을 손쉽게 사용할 수 있다.

설정 가이드

1. VS Code 마켓플레이스에서 Cline 또는 Kilo 설치

2. 설정(Settings) 메뉴 진입 (톱니바퀴 아이콘) 또는 버전에 따라 Use you own API key 클릭.

3. API Provider를 "OpenAI Compatible"로 선택 (Z.ai 전용 메뉴가 없다면)

4. 아래 정보를 입력:

| Base URL | Coding Plan 사용자:https://api.z.ai/api/coding/paas/v4일반/무료 사용자: https://open.bigmodel.cn/api/paas/v4 |

| API Key | 발급받은 Z.ai API Key 입력 |

| Model ID | glm-4.7 또는 glm-4.5-flash 등 |

Kilo 등 일부 도구에서는 '주소 입력' 란에 대시보드 URL(apikey-list)을 넣는 실수를 하기 쉽다. 반드시 위 표의 API 엔드포인트 URL을 정확히 입력해야 한다.

ex) 연동 확인

- 좌측 하단에서 언제든 모델 변경도 가능하다.

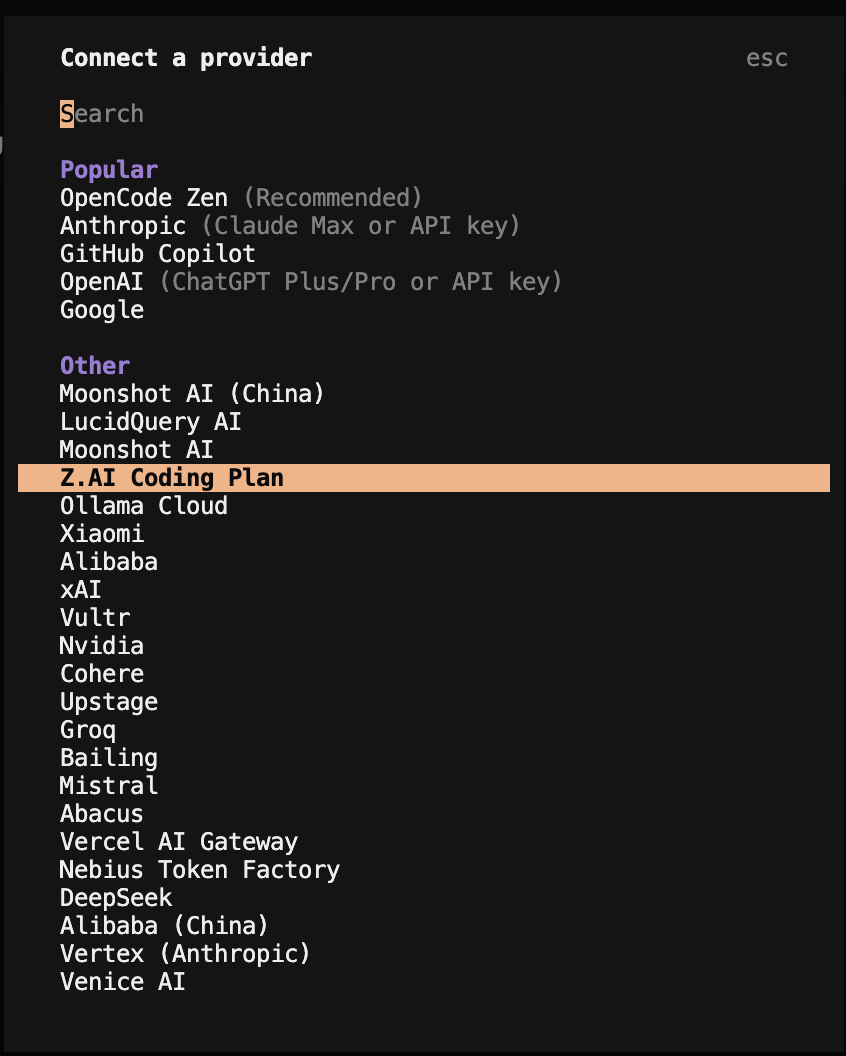

8. OpenCode 연동 설정

OpenCode에서 Z.ai GLM을 사용하려면 opencode.json 설정 파일을 수정한다.

Coding Plan 사용 시

{

"provider": {

"zai-coding": {

"npm": "@ai-sdk/openai-compatible",

"name": "Z.AI Coding Plan",

"options": {

"baseURL": "https://api.z.ai/api/coding/paas/v4",

"apiKey": "{env:ZAI_API_KEY}"

},

"models": {

"glm-4.7": {

"name": "GLM-4.7 (Coding Plan)",

"limit": { "context": 200000, "output": 16384 }

}

}

}

}

}ex) apiKey 영역은 본인의 키 입력

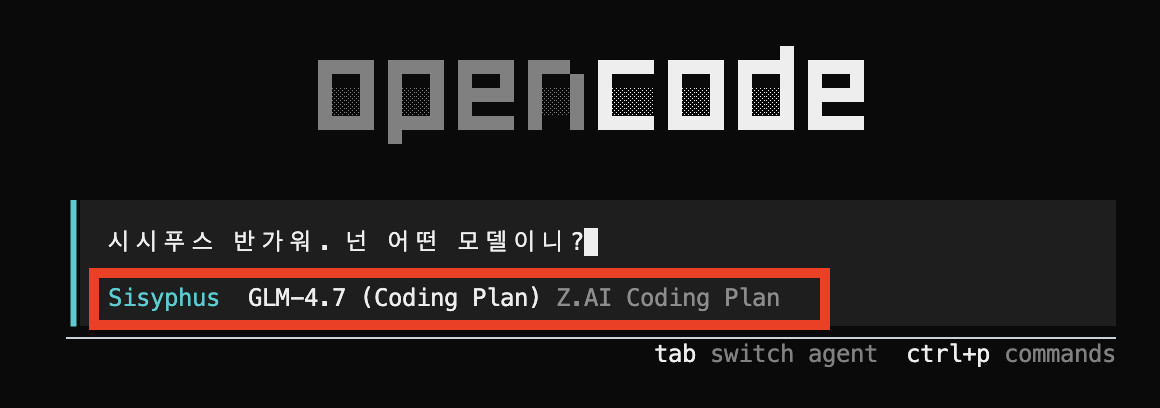

oh-my-opencode 에이전트 설정

oh-my-opencode를 사용한다면 에이전트별로 모델을 지정할 수 있다:

{

"agents": {

"Sisyphus": { "model": "zai-coding/glm-4.7" },

"oracle": { "model": "zai-coding/glm-4.7" },

"librarian": { "model": "zai/glm-4.5-flash" },

"explore": { "model": "zai/glm-4.5-air" }

}

}ex)

- 가성비 조합 : 메인 작업(GLM-4.7) + 단순 작업(GLM-4.5-Flash)

- 크로스 모델 조합 : 기획/설계는 Claude 4.5 Sonnet / Opus에게 맡기고, 실제 코딩 구현은 가성비 좋은 GLM-4.7에게 실행시키는 전략

OMO 3.0 Multi-Provider 비용 최적화

Oh-My-OpenCode 3.0에서는 Categories 기능을 통해 작업 유형별로 다른 모델을 자동 매핑할 수 있다. Z.ai GLM을 일상 작업용으로 설정하면 비용을 크게 절감할 수 있다.

| Category | 용도 | 권장 모델 | 비용 |

|---|---|---|---|

deep-thinking |

복잡한 아키텍처, 계획 | Opus 4.5 | $15 / $75 |

balanced |

일반 코딩 | GLM-4.7 | $0.6 / $2.2 |

quick |

빠른 수정, 간단한 질문 | GLM-4.5-Flash | 무료 |

이 조합을 사용하면 모든 작업을 Claude로 처리할 때 대비 월 비용을 70~80% 절감할 수 있다.

복잡한 기능 구현 시 /plan으로 Prometheus를 시작하고, 계획 수립에는 Opus를, 실제 구현(/start-work)에는 GLM-4.7을 사용하면 품질과 비용 모두 최적화할 수 있다.

ex) omo 실행 예시

- 다음과 같은 오류가 발생한다면

ex) /connect 를 이용해서 직접 연결하자.

- 정상 연동 확인

9. 고급 기능

9.1 Context Caching(이전 대화 내용 저장해두고 재사용)

Z.ai는 Context Caching 기능을 제공하여 반복적인 프롬프트 사용 시 비용을 절감할 수 있다.

| 구분 | 일반 입력 | 캐시된 입력 | 절감률 |

|---|---|---|---|

| GLM-4.7 | $0.60/1M | $0.11/1M | ~82% |

| GLM-4.5-Air | $0.20/1M | $0.03/1M | ~85% |

현재 캐시 저장 비용이 무료로 제공되고 있다. 이 기간을 활용하면 추가 비용 없이 캐싱의 이점을 누릴 수 있다.

9.2 Thinking Mode(답변 전 AI가 생각하는 과정을 거침)

GLM-4.7은 세 가지 사고 모드를 제공하여 복잡한 작업에서 정확도를 높일 수 있다:

Interleaved Thinking (인터리브드)

- 모든 응답과 도구 호출 전에 "추론" 단계를 실행

- 복잡한 디버깅 작업에서 환각(AI가 사실이 아닌 내용을 생성하는 현상) 감소

Preserved Thinking (보존형)

- 멀티턴 대화에서 모든 사고 블록을 자동 보존

- 처음부터 다시 추론하지 않고 기존 추론 재사용

- 장기적인 복잡 작업에 적합

Turn-level Thinking (턴 레벨)

- 세션 내에서 턴별로 추론을 제어할 수 있음

- 간단한 요청: 사고 비활성화 → 지연/비용 감소

- 복잡한 작업: 사고 활성화 → 정확도/안정성 향상

API 파라미터 예제

Thinking Mode를 API에서 활성화하려면 thinking 파라미터를 설정한다:

{

"model": "glm-4.7",

"messages": [...],

"thinking": {

"type": "enabled",

"budget_tokens": 8192

}

}{

"model": "glm-4.7",

"messages": [...],

"thinking": {

"type": "enabled",

"budget_tokens": 8192,

"preserve": true

}

}budget_tokens는 추론에 사용할 최대 토큰 수를 지정한다. 값이 클수록 깊은 추론이 가능하지만, 응답 시간과 비용이 증가한다. 일반적으로 8192~16384 범위를 권장한다.

10. 벤치마크(성능 측정 테스트) 및 성능

GLM-4.7의 주요 벤치마크 결과는 다음과 같다 (2026년 1월 기준):

| 벤치마크 | GLM-4.7 | 비고 |

|---|---|---|

| SWE-bench Verified(소프트웨어 버그 수정 능력) | 73.8% | Claude 5 Sonnet 수준 |

| SWE-bench Multilingual | 66.7% | 다국어 코딩 |

| Terminal Bench 2.0 | 41% | 터미널 작업 |

| Tool-calling(외부 도구 호출) 성공률 | 90.6% | Claude 5 Sonnet에 근접 |

| τ²-Bench | 87.4 | 오픈소스 최고 |

| AIME 2025(미국 수학 경시대회) | 95.7% | 고난도 수학 문제 해결 |

| GPQA-Diamond(박사급 과학 지식) | 85.7% | 물리/화학/생물 전문 문제 |

| HLE(인류 최종 시험, 최고난도) | 42.8% | 전문가도 어려운 종합 문제 |

(출처: Z.ai 공식 블로그)

Hacker News 등 커뮤니티 의견에 따르면 GLM-4.7은 "Claude Code의 약 80% 수준"으로 평가되는 경우가 많다.

이는 주관적 평가이며, 실제 성능은 작업 유형에 따라 다를 수 있다.

11. 팁 및 주의사항

엔드포인트 혼동 주의

Coding Plan 구독자가 일반 API 엔드포인트를 사용하면 다음 오류가 발생할 수 있다:

- "Authorization Failure"

- "Insufficient Balance"

https://api.z.ai/api/coding/paas/v4를 사용하자.

속도 이슈

일부 사용자들이 서비스 속도가 느려졌다는 보고가 있다. 이는 신규 사용자 급증으로 인한 것으로 추정된다.

대체로 사용 가능한 수준이지만, 응답 지연이 발생할 수 있음을 감안하자.

실전 팁

- 무료 모델로 시작: GLM-4.5-Flash로 먼저 테스트해보자

- Coding Lite 추천: 대부분의 개발자에게는 $3/월 Lite로 충분하다

- Context Caching 활용: 반복 작업 시 비용을 80% 이상 절감할 수 있다

- 하이브리드 전략: 메인 작업은 GLM-4.7, 보조 작업은 무료 모델 조합

- 타임아웃 설정: 응답 지연을 대비해 API_TIMEOUT_MS를 여유있게 설정하자

12. FAQ

13. 참고 자료

커뮤니티 및 도구

- GLM-4 GitHub - 오픈소스 모델

- GLM CLI - CLI 도구

- HuggingFace - GLM-4.7

- OpenRouter - GLM-4.7

- Cline + Z.ai 연동

이 글은 2026년 1월 기준 Z.ai 공식 문서와 커뮤니티 정보를 바탕으로 작성되었다. 가격, 기능, 정책은 언제든 변경될 수 있으므로, 적용 전 공식 사이트에서 최신 정보를 확인하는 것을 권장한다.

'AI > OpenCode(OhMyOpencode)' 카테고리의 다른 글

당신이 좋아할만한 콘텐츠

소중한 공감 감사합니다